"Deep fake" pornografija - Družbeni, ne tehnološki problem!

Avstralka Noelle v TEDx Talku pove, da je bila stara 18 let, ko je naložila svojo fotografijo v Google, da bi videla, kje vse se nahaja, in šokirana ugotovila, da tudi na številnih pornografskih straneh. Povsem vsakdanje fotografije so namreč vzeli z njenih profilov na družabnih omrežjih in jih računalniško obdelali, tako da so jih lahko objavili na pornografskih straneh.

Nekoliko kasneje je ugotovila, da je bil njen obraz prilepljen na telesa odraslih porno igralk v pornografskem videu. A Noelle je le ena izmed mnogih, povsem običajnih žensk, ki so jim neznani storilci vzeli fotografije z družabnih omrežij, jih obdelali in zlorabili za pornografijo.

Tovrstna manipulacija fotografij se je seveda začela že dolgo pred zločinom nad Noelle, le da so bile žrtve ponavadi zvezdnice, ki so jim uporabniki s programi za obdelavo fotografij postavili obraze na telesa porno igralk. Leta 2017 pa se je na Redditu pojavila tovrstna kreacija, ki pa se je premikala. Zadevo je raziskovala novinarka Motherboarda Sam Cole, ki je vedela, da ne zvezdnica in ne porno igralka nista privolili v to, in je ugotovila, da je uporabnik z vzdevkom »deepfakes« uporabil tehnike, ki so jih raziskovalci umetne inteligence prepustili v uporabo javnosti. V svojem TEDx Talku je povedala, da je vprašala uporabnika, ali je razmislil o posledicah, on pa ji je odgovoril, da je le programer, ki ga zanima strojno učenje. Dodal je še, da lahko »vsako tehnologijo uporabimo v slabe namene in da se tega ne da ustaviti. Mislim, da moj algoritem ni drugačen kot tehnologija, ki so jo uporabili za pokojnega Paula Walkerja v Hitrih in drznih. Dobro je, da se več običajnih ljudi ukvarja z raziskovanjem strojnega učenja.« Ti globoki ponaredki so pritegnili pozornost javnosti predvsem zaradi tehnologije, pa čeprav so mnogi opozarjali na posledice, ki jih tovrstna globoko ponarejena pornografija lahko ima za družbo.

Nasilje nad ženskami in zaton demokracije

Začelo se je s poniževanjem in z zlorabo žensk, nato pa se je fokus izredno hitro preusmeril na globoko ponarejene politične video vsebine, pa čeprav jih je v primerjavi s pornografijo na spletu le za mišjo dlako. Mnogi mediji so se senzacionalistično spraševali o novi grožnji demokraciji, a dejanski problem ostaja pornografija. Pri globokem ponarejanju storilec torej vzame obraz ženske, ga animira v izraze nekoga drugega in ji s tem odvzame nadzor nad njim ter ga uporabi za nekaj, česar si ta ženska nikoli ni želela. Zakaj ženska? Ker so, kot poroča MIT Technology Review, raziskave podjetja Sensity iz septembra 2019 jasno pokazale, da je med globoko ponarejenimi videi na spletu od 90 do 95 odstotkov pornografskih posnetkov brez dovoljenja in velika večina teh je ženskih.

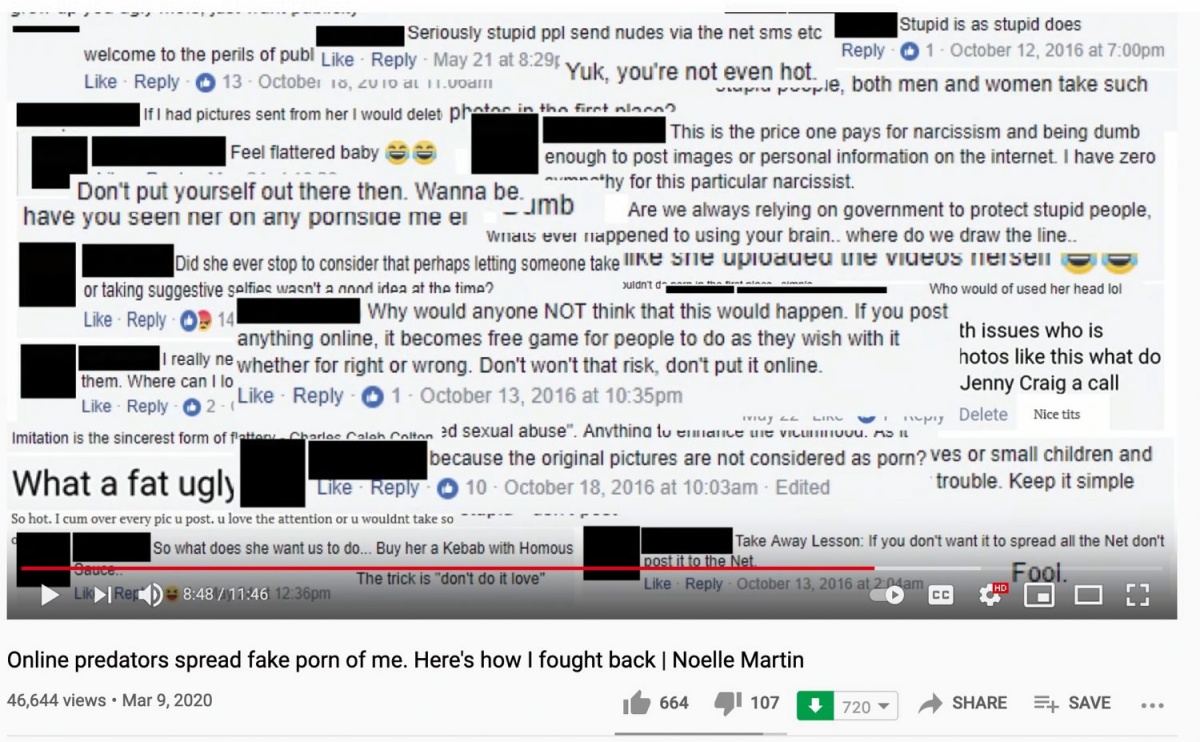

Noelle je v TEDx Talku povedala, da se je seveda obrnila na policijo in državne institucije, ki pa ji niso mogle pomagati, saj so pornografske strani imele gostovanje v tujini, od tam pa so bili tudi storilci. Svetovali so ji, naj se obrne na posamezne spletne strani in jih prosi, da odstranijo njene podobe. Nekatere so ji pomagali, drugi ne, fotografije pa so se vedno bolj širile po spletu. Nato se je odločila, da bo spregovorila, da bi svojo zgodbo napisala na novo. Njenim javnim nastopom so sledili grobi, nesramni in žaljivi komentarji. A ni odnehala in je poiskala politične predstavnike, ki so že pripravljali nove zakone. Tako je postala obraz nove zakonodaje in je v svoji državi dosegla dejanske spremembe.

Za ustvarjanje globoko ponarejenih pornografskih videov so bili včasih potrebni ogromno materiala, dober računalnik in programska oprema, zdaj pa ga je mogoče narediti že za mikrotransakcijo. Z razvojem je torej potrebnih vedno manj podatkov, orodja postajo vse bolj dostopna, uporabniki pa vse bolj povezani, saj med drugim na forumih delijo nasvete, kako ustvariti tovrstne video vsebine, pa tudi, kako »ciljati« posameznice. Ustvarjanje teh vsebin, ki se v veliki meri uporabljajo za nadlegovanje, ustrahovanje, poniževanje in izsiljevanje žensk, pa naj gre za zvezdnice, novinarke ali povsem običajne ženske, je torej vedno lažje. Med pandemijo pa se je število digitalnih zlorab še povečalo, je v pogovoru za MIT Technology Review povedala Sophie Mortimer iz organizacije Revenge Porn Helpline.

Tovrstne video vsebine pa so lahko tudi orodje političnega pritiska; tako sta med drugim bili žrtvi tudi indijska in brazilska novinarka. Po poročanju Reutersa je brazilska novinarka kritično poročala o odzivih brazilske vlade med pandemijo in kmalu se je na spletu pojavila množica memov z njenim obrazom v pornografskih pozah. Podobno je bila zaradi kritičnega poročanja raziskovalna novinarka v Indiji žrtev, ko se je pojavila v globoko ponarejenih pornografskih videih.

Sam Cole v TEDx Talku razlaga, da žrtve, s katerimi je govorila, pravijo, da jim ne pomaga, da vedo, da video ni resničen, vseeno imajo namreč občutek, kot da jih je ogromno ljudi videlo seksati z neznancem na internetu. Storilce je izredno težko najti, kaj šele tožiti, saj se skrivajo za izmišljenimi imeni in prihajajo iz različnih delov sveta, še težje pa je ustaviti širjenje.

Odgovornost

Začelo se je z glavami slavnih v pornografskih videih, nato je leta 2019 sledila aplikacija DeepNude za slačenje oblačil s fotografij žensk, ki so jo sicer hitro prepovedali, a koda še zmeraj kroži naokrog. Nato je sledil Telegramov bot, ki je ob pomoči umetne inteligence ustvarjal in širil fotografije slečenih žensk, tudi mladoletnih. Uporabniki so poslali fotografijo ženske, ki so jo želeli videti golo, bot je potem ustvaril podobo te ženske brez obleke oziroma – povedano natančneje – je ustvaril lažno golo telo. Večina slik je bila vzeta z družabnih omrežij ali pa iz zasebne komunikacije, seveda brez vednosti žrtev. Uporabljena pa je bila različica programske opreme, ki je bila prisotna v aplikaciji DeepNude. Prvotna analiza podjetja Sensity je pokazala, da so vzeli fotografije vsaj 100.000 ženskam, naknadna analiza pa je dvignila to oceno na vsaj 680.000. Uporabniki so potrebovali le eno fotografijo. Ko so jih »slekli«, pa so bile te fotografije razširjene med množični uporabniški zbir aplikacije. Giorgio Patrini, direktor podjetja Sensity, je za Wired opozoril, da kljub slabemu končnemu rezultatu Telegramovega bota pri trenutni hitrosti razvoja tehnologije kmalu ne bo mogoče ločiti med kopijo in izvirnikom. Ne glede na kakovost pa gre pri globoko ponarejeni pornografiji za napad na osebo, saj so prsi, četudi računalniško generirane, razgaljene in postavljene javnosti na ogled.

Tako globoko ponarejene pornografija v 2020 ni bila več le v domeni skritih skupnostih. Podjetje Sensity razkriva, da je bilo v 2020 mesečno naloženih na pornografske strani približno tisoč globoko ponarejenih videov. Ustvarjanje globoko ponarejene pornografije je postalo tudi posel, nekateri jo prodajajo direktno naročniku ali pa zaslužijo v skupnostih z oglasi, saj video vsebine na pornografskih straneh obkrožajo oglasi, ki lahko prinašajo denar. Čeprav nekatere strani ne dovolijo globoko ponarejene pornografije, pa se aktivno ne ukvarjajo z njenim odstranjevanjem. Pornhub je tovrstne vsebine sicer prepovedal, a jih je, denimo, še vedno treba kontaktirati, če želite tovrstno vsebino odstraniti. Giorgio Patrini je za Wired še dodal, da bodo ljudje te vsebine brez posledic nalagali, dokler jih pornografske strani ne bodo začele odstranjevati, a dokler nimajo močnega razloga, da jih odstranijo, se to ne bo zgodilo. In res, kot je povedal Alex Hawkins iz podjetja xHamster, sploh nimajo posebnih pogojev uporabe za globoko ponarejene videe, ampak jih obravnavajo kot vse ostale vsebine, ki so ustvarjene brez privoljenja. Če ni privolitve sodelujočih, jih bodo odstranili, se pa je seveda treba najprej pritožiti. Odgovornost odstranitve tovrstnih videov je torej na strani žrtev in brez njenega posredovanja se ne zgodi nič.

Tehnologija, družba, regulacija

Ker globoko ponarejeni videi temeljijo na umetni inteligenci, nekateri iščejo tudi rešitev v tej smeri. In seveda je na voljo že nekaj sistemov, ki zaznajo tovrstne vsebine, a podobno kot pri virusih in zlonamerni programski opremi hitrost razvoja obrambe ne doseže hitrosti ustvarjanja tovrstnih vsebin. Hany Farid, profesor na univerzi UC Berkley in strokovnjak za globoko ponarejene vsebine, je lani za Forbes povedal, da je razmerje 100 : 1 v korist tistih, ki tovrstne video vsebine delajo. Seveda bi pomagalo, če bi se tega proaktivno lotila družabna omrežja in pornografske strani, a zanašanje na zasebna podjetja, da bodo uredila družbene probleme, se nam doslej ni izšlo. Kot je za Business Insider srčiko problema lepo povzela Ksenia Bakina iz nevladne organizacije Privacy International: »Globoko ponarejena pornografija ni tehnološki problem, ampak družbeni. Tehnologija omogoča širjenje, a tovrstno zlorabo napaja seksističen, mizogin, nadzorovalen in nasilen odnos.« A za boj proti njej bomo potrebovali tudi ustrezno zakonodajo.