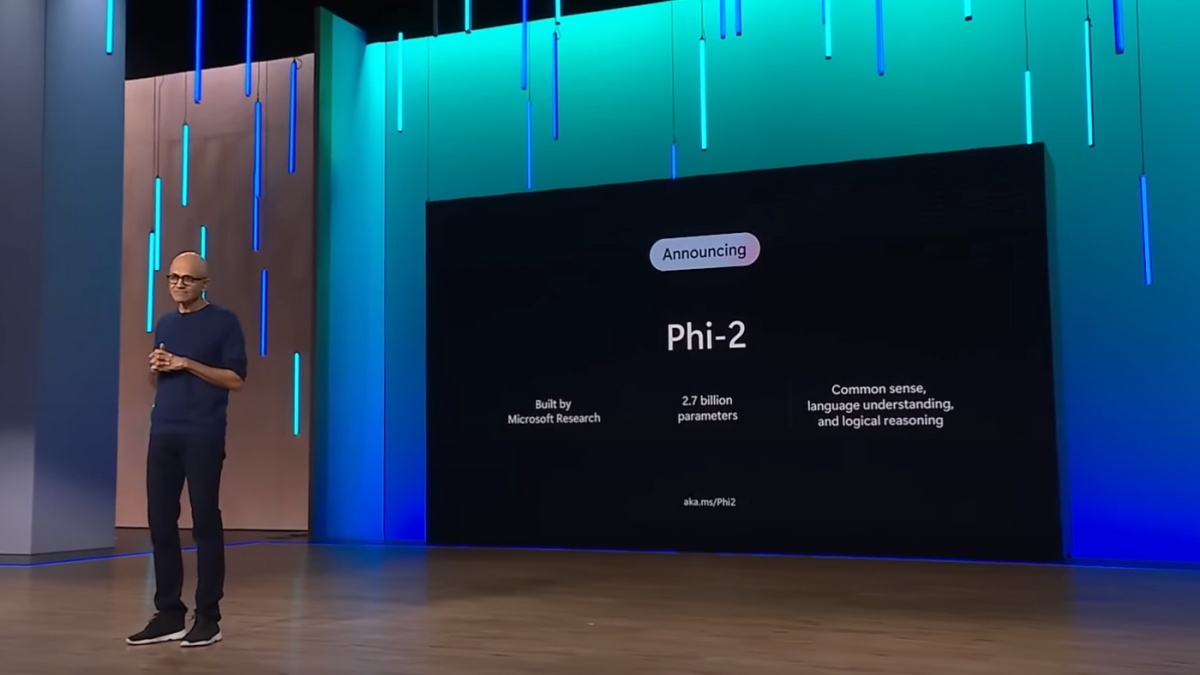

Microsoft pri umetni inteligenci stavi na male jezikovne modele

Ko govorimo o umetni inteligenci, običajno pišemo o velikih jezikovnih modelih (LLM), ki so prilagojeni opravljanju najrazličnejših nalog, še najraje povezanih z besedilom (ali prevedljivih vanj). A svoje mesto imajo tudi mali jezikovni modeli (SLM), kakršen je najnovejši Microsoftov Phi-2.

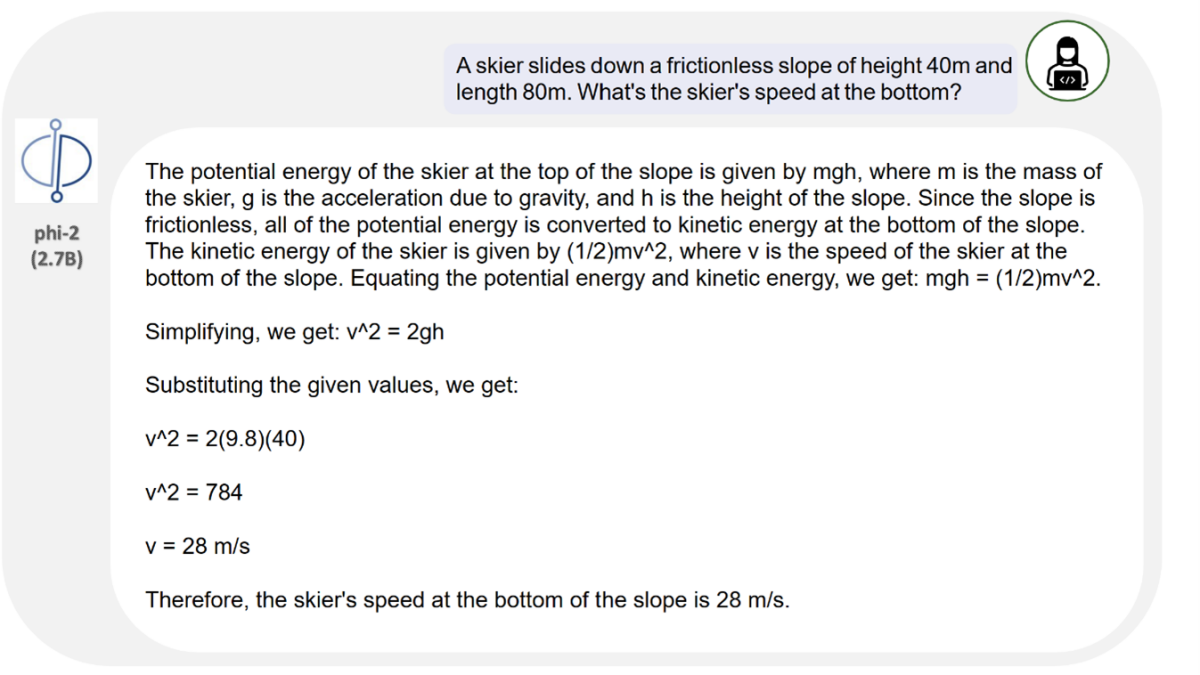

Zakaj bi včasih želeli manj, ni težko uganiti. Veliki jezikovni modeli so resda sposobnejši, njihovi odgovori pa v povprečju malenkost boljši, a so energetsko potratni in računsko zahtevni. Za uporabo potrebujemo dostop do računske moči, ki jo bodisi zagotovimo sami bodisi ponudnik modela, sami pa plačujemo za dostop prek API. Mali modeli pa lahko tečejo že na zelo povprečni domači opremi.

To je smisel Microsoftovega Phi-2, ki ga je podjetje predstavilo minuli torek. Prvi model Phi-1 je bil uporabljal 1,3 milijarde parametrov, Phi-2 pa jih ima 2,7 milijarde. To je precej manj od sedmih milijard, ki jih ima Metina Llama 2-7B, da ne omenjamo GPT-4. Microsoft trdi – česar neodvisno še ni nihče preveril – da je Phi-2 enako zmogljiv kot modeli s 25-krat več parametri. Microsoft tudi izrecno poudarja, da je model boljši od Googlovega Geminija Ultra.

Phi-2 je namenjen uporabi na domačih napravah, ki pa mora biti za zdaj striktno nekomercialna. Izdan je pod licenco, ki dovoljuje le nekomercialno, neprofitno, raziskovalno rabo (Microsoft Research License).