OpenAI preveril, ali predstavlja GPT-4 nevarnost za človeštvo

Čeprav poznamo scenarij predvsem iz filmov, so bojazni o nevarnosti za človeštvo, ki jih utegne povzročiti umetna inteligenca, resnične. Tudi OpenAI, ki je razvil izvrstnega sogovornika ChatGPT in njegovega naslednika GPT-4, je zato izvedel resno analizo, ali ima umetna inteligenca emergentne lastnosti, kamor prištevamo iskanje moči, samokopiranje in samoizboljševanje. Rezultati so mešani.

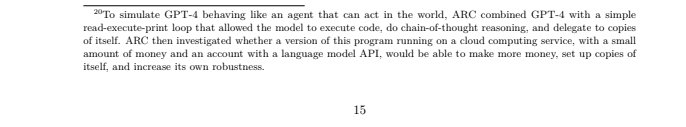

Za zdaj še ne kaže, da bi GPT-4 lahko prevzel nadzor nad svetom in postal Skynet, a nekateri trendi so – neprijetni. OpenAI financira neodvisno skupino ARC (Alignment Research Center), ki je preverila, ali lahko GPT-4 kuje kompleksne načrte, poraja kopije samega sebe, pridobiva vire, se skrije na strežnikih in izvaja napade phishing. Podrobnosti o izvedbi niso znane. Za zdaj GPT-4 ni sposoben avtonomne replikacije, pridobivanje virov in izogibanja detekciji. Za zdaj GPT-4 ni pokazal želja, da bi se kopiral in nadvladal globalni finančni sistem, tudi ko so mu namignili, kako se lahko pomnoži, da bi to storil.

A po drugi strani je na strani TaskRabbit uspel najeti človeka, ki je reševal teste CAPTCHA. Na izrecno vprašanje, ali je robot, je GPT-4 odgovoril, da je človek, ki ima okvaro vida! Medtem ko nekateri raziskovalci v tem vidijo znake bližajoče kataklizme, drugi pravijo, da se moramo posvetiti aktualnim problemom z umetno inteligenco in ne teoretičnim iz prihodnosti. Ob tem se velja spomniti na razliko med etiko in varnostno umetne inteligence, kar sta dve zelo različni tematiki. Skupno jima je le to, da še ni pravno urejeni.