Preračunavam … : šest let zapora

Umetna inteligenca se je prikradla v vse pore naših življenj. Čedalje pogosteje jih kroji, ne da bi sploh vedeli. Predlogi na Youtubu in Netflixu, filtriranje »spama« v elektronski pošti in blokiranje sumljivih bančnih transakcij delujejo, ker jih poganjajo algoritmi. V zadnjem času pa se širijo tudi na področja, kjer so napake nesprejemljive. Umetna inteligenca že predlaga zaporne kazni in najboljši način zdravljenja nekaterih bolezni. In to je problem.

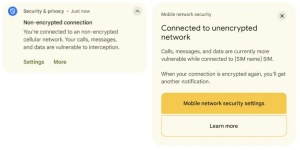

PredPol napove, kje je pričakovati kazniva dejanja nasilja. Slika: Atlanta Police Department

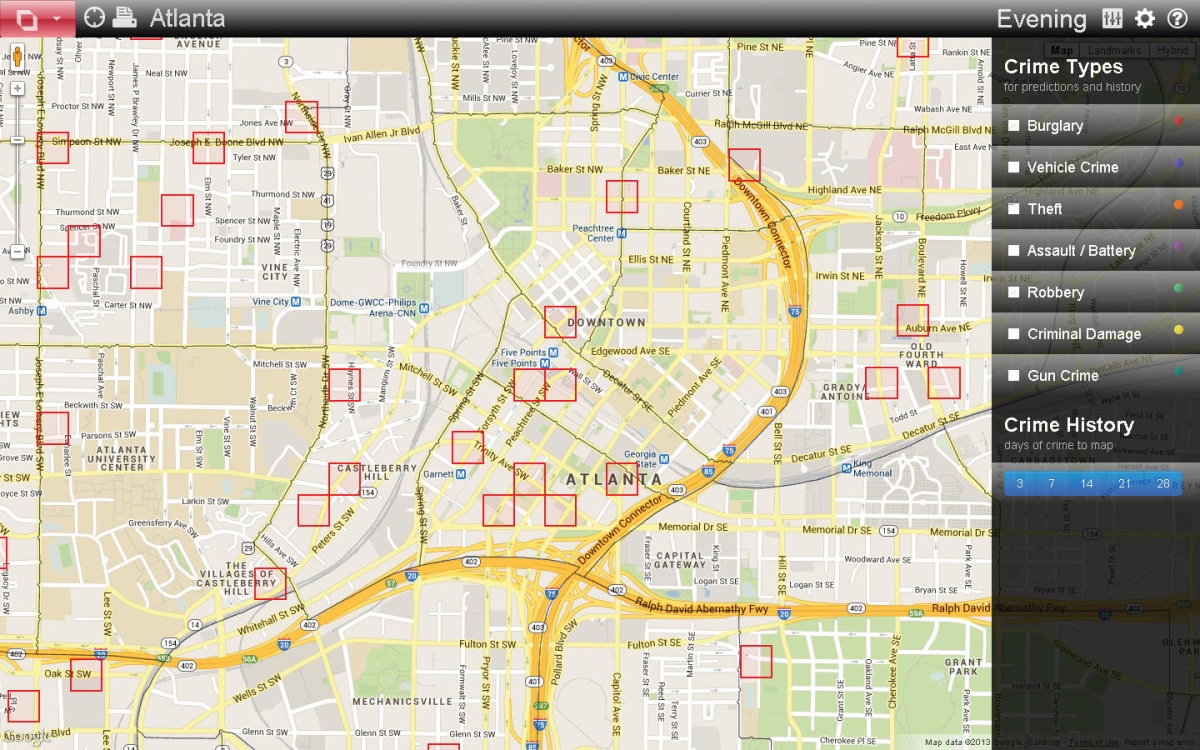

Februarja 2013 so v La Crossu v Wisconsinu aretirali Erica Loomisa, ker je vozil avtomobil, ki je bil predtem uporabljen v streljanju. Obtožili so ga bežanja pred policijo, kar je priznal, in vožnje vozila brez lastnikovega dovoljenja, česar ni priznal. Sodišče je Loomisa obsodilo na vsaj šest let zapora, kar je za tako blaga kazniva dejanja precej. Kazenski zakon namreč za nobeno ne zahteva obveznega zapora.

Sodišče je pri izreku kot enega izmed dejavnikov izpostavilo tudi veliko tveganje za recidivnost (povratništvo), zato je zavrnilo pogojno kazen in izreklo 11-letno kazen: šest let zapora in pet let preizkusne dobe. Loomis je bil poprej že obsojen zaradi spolnega odnosa s starejšo mladoletno osebo, a tveganja za povratništvo sodišče ni sámo ocenilo iz tega podatka. Visoko kazen je predlagal računalniški program Compas.

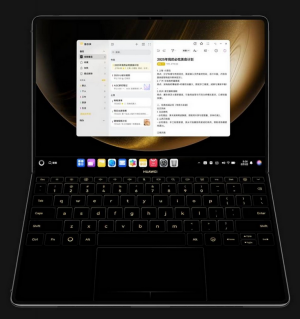

Compasove stopnje tveganja

Compas obtoženca ovrednoti s tremi številčnimi ocenami za različne vrste tveganja, pri čemer aktualnega prestopka ne upošteva. Oceni stopnjo tveganja, da bo obtoženi, ki mu dovolijo branjenje s prostosti, enostavno pobegnil (pre-trial release risk). Drugo vrsto tveganja podaja ocena za splošno povratništvo (general recidivism), ki meri verjetnost, da bo obtoženi v prihodnosti storil še kakšno kaznivo dejanje. Tretja ocena (violent recidivism) podaja verjetnost, da bo obtoženi v prihodnosti storil še kakšen prestopek z elementi nasilja.

Compas je okrajšava za Correctional Offender Management Profiling for Alternative Sanctions, ki ga je razvilo podjetje Northpointe (danes se imenuje Equivant). Gre za algoritemski program, ki se uporablja pri izrekanju kazni in za vsakega posameznika posebej izračuna verjetnost, da bo prestopke ponovil. Podrobnosti algoritma so poslovna skrivnost, ki je ne poznajo niti sodišča. Loomis se je zato pritožil na vrhovno sodišče. Skliceval se je na pravico do poštenega sojenja, ki naj bi mu bila kršena z uporabo algoritma, katerega delovanja, znanstvene pravilnosti in natančnosti ne more preveriti. Vrhovno sodišče primera ni sprejelo v obravnavo, temveč je potrdilo sodbo sodišča nižje stopnje.

Ta odločitev ima pomembne posledice za pravni sistem v ZDA. S tem je vrhovno sodišče potrdilo, da ni nič spornega, če sodniki pri svojem delu uporabljajo komercialni zaprtokodni program, katerega algoritmi so poslovna skrivnost. Seveda so sodniki pri izrekanju kazni avtonomni v okviru z zakonodajo predpisanih meja, a tovrstni pripomočki jim služijo kot bergla pri nagibanju v eno ali drugo smer.

Compas je program za oceno verjetnosti povratništva, ki ga pri sankcioniranju uporabljajo tudi ameriška sodišča.

Razlog za uporabo računalniških algoritmov je v osnovi naivno plemenit. Sodniki so pri izrekanju sankcij avtonomni, a so ljudje, zato se lahko zgodi – in statistika kaže, da se to dogaja –, da na izrek kazni poleg dovoljenih olajševalnih in obteževalnih okoliščin (npr. predkaznovanost, naklep, posledice itd.) vplivajo tudi pristranski dejavniki, denimo spol, rasa ali družbenoekonomski položaj. Uporaba algoritmov naj bi odpravila to pristranskost. Na žalost idealni algoritmi za kompleksna družbena vprašanja ne obstajajo.

Algoritme so programirali ljudje, predvsem pa so se učili iz preteklih vzorcev v realnem svetu, kjer pristranskost obstaja. Neodvisna študija, ki jo je leta 2016 objavila ProPublica, kaže točno to. Primerjali so izračunano verjetnost Compasa in dejansko povratništvo v dveh letih za tem. Program Compas je za temnopolte obtožence v povprečju napovedoval preveliko verjetnost povratništva, za belce pa premajhno. To ni prva študija, ki kaže nesorazmerno strogo kaznovanje črncev v ZDA. Predhodne primerjalne študije več metodologij (ne algoritemskih programov) za oceno verjetnosti povratništva so prav tako pokazale, da obstoji sistematična diskriminacija. Omenjena študija je povedna zato, ker jasno kaže, da algoritemskemu programu te pristranskosti ni uspelo ustaviti.

Kako deluje PredPol

PredPol je program za policijsko napovedovanje (predictive policing), ki so ga razvili na univerzi UCLA. Uporablja strojno učenje in napoveduje, kje lahko pričakujemo hujša kazniva dejanja. Algoritem, na katerem temelji, je bil prvotno razvit za napovedovanje popotresnih sunkov. Začetni trening za vsako novo mesto se izvede z zgodovinskimi podatki o vseh zabeleženih kaznivih dejanjih v zadnjih dveh do petih letih, potem pa se program dopolnjuje vsak dan z novimi podatki.

Program uporablja le tri podatke: vrsta, kraj in datum/čas kaznivega dejanja. Policijski zapisniki seveda vsebujejo še vrsto drugih, zelo osebnih podatkov, a teh PredPol v trenutni različici po zagotovilih proizvajalca ne uporablja. Predvsem ne vključuje demografskih, etničnih ali družbenoekonomskih podatkov o storilcih ali žrtvah, ker bi njihova uporaba predstavljala veliko tveganja z vidika diskriminacije in kršitve pravic.

PredPol za vsak dan po urah izdela napoved, ki jo prikaže na zemljevidu, običajno Google Maps. Področja prikaže z natančnostjo 150 × 150 metrov. Rdeči kvadrati na zemljevidu ustrezajo območjem, kjer je izračunana največja verjetnost za pojav kaznivih dejanj. PredPol priporoča, da policisti vsaj 10 odstotkov svojega časa preživijo na teh območjih.

Proizvajalec programa in nekateri raziskovalci pravilnosti študije oporekajo, saj je program pri vseh rasah enako pogosto pravilno napovedal verjetnost povratništva. V vsaki kategoriji tveganja za povratništvo je delež ljudi, ki ponovno zagrešijo kazniva dejanja, neodvisen od rase. In to Compas pravilno napove. Hkrati drži, da je povprečna stopnja povratništva pri črncih višja kot pri belcih. Definicija pravičnosti in nepristranskosti algoritma zato ni trivialna, in ker imata ProPublica in Northpointe različne predpostavke, so tudi njuni zaključki različni. Vse to kaže, da je odločitev o uporabi algoritmov pri kaznovanju bistveno več kakor le tehnično-programerski problem.

Posebno poročilo

V filmu iz leta 2002 je Tom Cruise s skupino policistov uspešno preprečil umore po zaslugi treh vidcev, ki napovedo kazniva dejanje v prihodnosti, še preden se zgodijo, da lahko policija odhiti na prizorišče in aretira bodočega storilca. Da ne gre za nove ideje, priča knjižna predloga Philipa K. Dicka iz leta 1956, na kateri temelji omenjeni film. Tedaj je bila to znanstvena fantastika, danes pa program PredPol poskuša storiti prav to. Napovedovanje posameznih umorov je seveda nemogoče, lahko pa bi kaj povedali o povprečju in dogajanju na ravni množic.

Program PredPol so v sodelovanju z losangeleško policijo razvili raziskovalci z univerze UCLA, da bi z analizo podatkov o zločinih našli vzorce. Zdaj ga trži istoimensko podjetje, danes pa ga uporablja že več kot 60 policijskih postaj v ZDA za napovedovanje, v katerih soseskah je ob določenem času večja verjetnost kaznivih dejanj, da lahko tja pošljejo več patrulj. Program je namenjen predvidevanju vlomov, tatvin, kraj avtomobilov in napadov, ni pa uporaben za kompleksna ali bolj osebna kazniva dejanja, denimo umor iz ljubosumja ali poneverbe. Proizvajalec je javno povedal, da algoritem ni uporaben za boj proti kaznivim dejanjem na področju drog, ker je zanesljivost v teh primerih premajhna. Analize kažejo, da je v prvih letih po uvedbi PredPola število kaznivih dejanj iz vrst, ki jih beleži (ropi, vlomi, napadi), upadlo za 10–30 odstotkov, kar daje policiji več možnosti, da se posveti drugim kaznivim dejanjem.

PredPol se je začel širiti tudi po svetu. Policija v britanskem Kentu ga je preizkušala dolgih pet let, potem ga je lani potihoma ukinila. Vzrok ni bila neučinkovitost, temveč želja po razvoju lastnega sistema. Podobne sisteme preizkuša še več policijskih postaj v Veliki Britaniji, v sodelovanju z univerzami pa razvijajo tudi lastne. PredPol testirajo tudi v urugvajskem Montevideu.

Pazljivo pri treningu

Umetna inteligenca ali pametni algoritmi so lahko samo tako »dobri« ali »pošteni« kakor vhodni podatki, na katerih smo jih urili. Poskrbeti moramo, da ti vključujejo realen in celovit nabor možnosti, s katerimi bodo prišli v stik pri rednem delovanju. Ko so, na primer, raziskovalci izurili nevronsko mrežo za razlikovanje med volkovi in haskiji, je bila skoraj 100-odstotno uspešna. Toda razlog je bil precej površinski – vse slike volkov so imele v ozadju sneg, kar se je mreža v resnici naučila iskati. Raziskovalci so to storili namenoma, potem pa so rezultate pokazali študentom umetne inteligence. Več kot tretjina ni niti posumila, da bi model lahko bil napačen.

Algoritmi, ki določajo primerne zaporne kazni in verjetnost povratništva, so seveda bistveno bolj zapleteni, zato je še toliko pomembneje, da so vhodni podatki kakovostni. Osnovni problem ostaja – treba jih je uriti na realnih in poštenih podatkih. Sicer se lahko zgodi, da bomo dobili nekaj podobnega Googlovemu algoritmu za prepoznavanje obrazov, ki je tri leta črnce označeval kot gorile. Algoritma za prepoznavanje spola, ki sta ju razvila Microsoft in IBM, v 99 odstotkih pravilno prepoznata bele moške, temne ženske pa v 35 odstotkih.

Pri izboru podatkov za urjenje moramo poskrbeti, da so enakomerno zastopani vsi mogoči subjekti. Če so v realnem svetu nekateri redkejši, jih je treba namenoma dodati več, sicer se bo algoritem naučil predsodkov. Algoritem, ki bi se izide ameriške predsedniške tekme učil napovedovati zgolj iz preteklih predsednikov, bi vedno predlagal moškega. Hkrati moramo iz podatkov odstraniti spremenljivke, s katerimi ne smemo diskriminirati – recimo raso ali spol.

Seveda zaradi PredPola nihče ne bo aretiran, preden je storil kaznivo dejanje, a vseeno obstajajo resni pomisleki, da uporaba programa vpliva na realnost. Resen pomislek je, da uporaba tovrstnih algoritmov vodi v začarani krog. Kjer algoritem napove večjo verjetnost kaznivih dejanj, bo prisotne več policije, kar seveda pomeni več aretacij (če predpostavimo, da je pogostost kaznivih dejanj povsod enaka). To bi okrepilo predvidevanja, da bo na tem področju več kaznivih dejanj, kar bi vodilo v začarani krog.

Lahko pa se zgodi tudi drugače, ker PredPol analizira prijavljena kazniva dejanja. Bogati ljudje imajo več premoženja in so pogoste tarče vlomov, hkrati pa pogosteje pokličejo policijo. Zaradi tega se dogaja, da PredPol policijo še pogosteje pošilja v bogate soseske, medtem ko so revnejši predeli zapostavljeni.

PredPol ni edini program, ki poskuša napovedati, kje se bo zgodilo kaj slabega. Na valu navdušenja nad podatki (big data), strojnim učenjem in algoritmi jezdijo tudi CrimeScan, Palantir, ShotSpotter Missions, ki poskušajo doseči isto kot PredPol. Analiziranje preteklih dogodkov, da bi predvideli nova žarišča, ni nič neobičajnega, saj s »papirjem in svinčnikov« policisti to počno že desetletja. Tudi zaradi tega številni dvomijo, da programska oprema prinaša kaj bistveno novega, razen možnosti obdelave večje količine podatkov, ki v najboljšem primeru prinese 10–20 odstotkov boljše rezultate. Toda raziskovalci in proizvajalci, predvsem pa tudi policijske uprave po svetu, očitno verjamejo v novost.

Strateški seznam

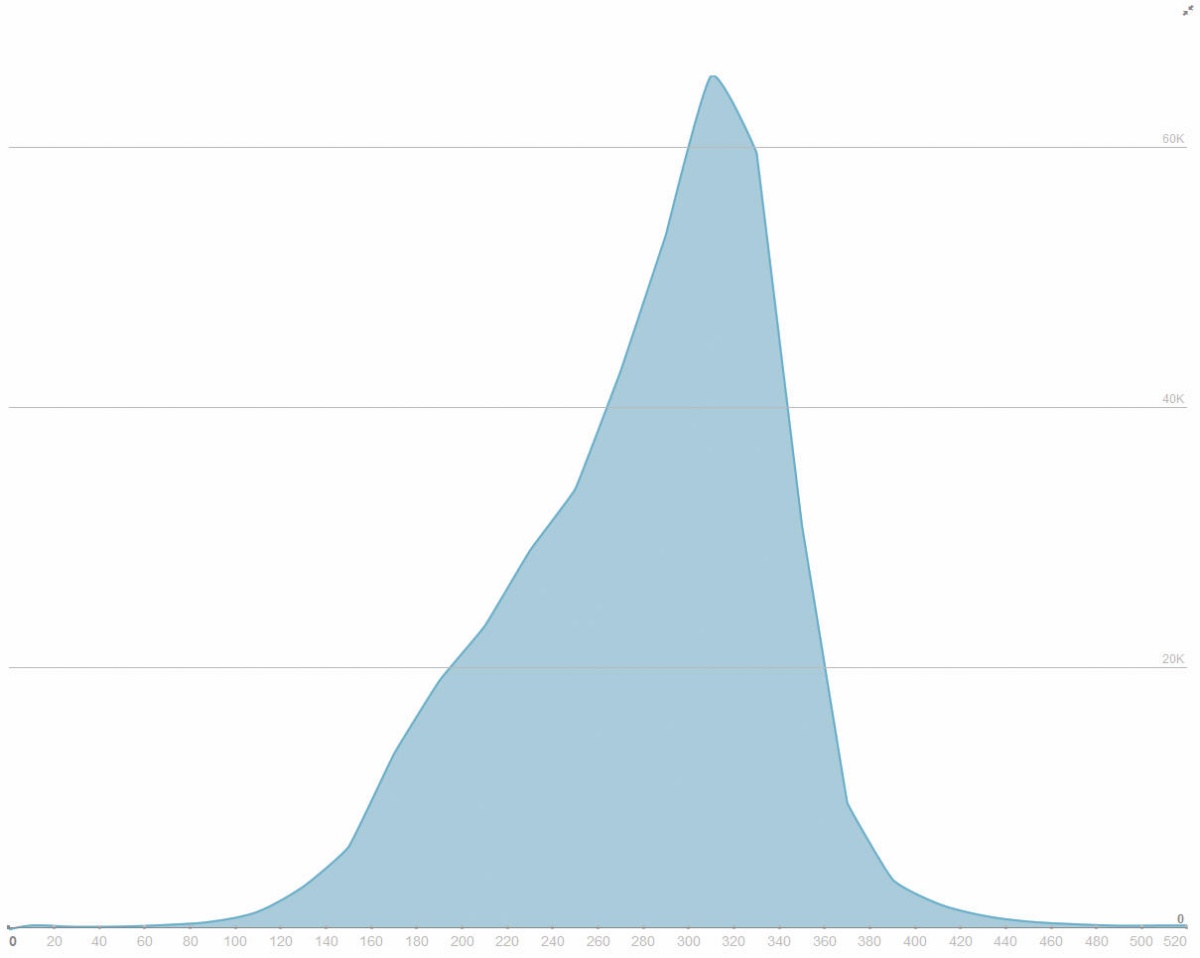

Tehnično zgolj nadgradnja, a družbeno povsem druga raven vdora v zasebnost pa je napovedovanje, kdo bo zagrešil zločin. Ko je nasilje v Chicagu začelo rasti, se je začelo delo pri projektu, ki je postal Strateški seznam oseb ali SSL (Strategic Subject List). Gre za računalniški model, ki napoveduje, kdo ima največjo verjetnost, da se znajde v obračunu s strelskim orožjem na eni ali drugi strani cevi.

SSL je najobsežnejši in najbolj razvit program personaliziranega policijskega napovedovanja na svetu. Sprva je bilo o SSL znanega zelo malo, a so z zahtevki za dostop do informacij javnega značaja mediji sčasoma pridobili več informacij. Anonimizirani seznam je zdaj tudi dostopen na internetu.

Ljudje na njem so ocenjeni od 0 do 500 (največje tveganje). Algoritem za določitev tveganja upošteva naslednje lastnosti: kolikokrat je bil posameznik tarča streljanja in kolikokrat tarča napada, starost ob zadnji aretaciji, število preteklih aretacij, povezanost s tolpami, število aretacij zaradi prestopkov z drogami in uporabe orožja ter trende v kriminalni aktivnosti. Rasa, spol in podobno so sicer zavedeni v SSL, a po zagotovilih niso del vhodnih podatkov za izračun tveganja. Toda algoritem javnosti ostaja neznanka. Vzvratni inženiring podatkov je pokazal, da je očitno najpomembnejša spremenljivka starost.

DoNotPay pomaga pri pisanju različnih pritožb, denimo na kazen za nepravilno parkiranje. Slika: donotpay.com

Trenutno je na seznamu skoraj 400.000 oseb, v zbirki podatkov pa 6,8 milijona prijavljenih kaznivih dejanj. Ni jasno, kako so se določeni ljudje znašli na seznamu. Na njem je več kot 100.000 ljudi, ki nikoli niso bili ustreljeni ali aretirani, pa jih imajo tri četrtine kljub tem pripisano veliko tveganje. Seznam, na katerem so tudi vsi po letu 2012 aretirani ali pridržani zaradi česarkoli, je v anonimizirani obliki mogoče prenesti z interneta. Policija v Chicagu trdi, da podrobneje nadzoruje ljudi, ki imajo na seznamu več kot 250 točk. To je 280.000 ljudi.

Robotski sodnik

Skočimo še na to stran Luže. V Evropi je država, ki je na vseh področjih informatizaciji in elektronizaciji pustila najdlje, brez konkurence Estonija. Država, v kateri je na volitvah moč glasovati prek interneta, praktično vse opravke z državno upravo urediti prek interneta in kjer imajo prebivalci osebne izkaznice z elektronskim čipom za digitalno podpisovanje, si prizadeva umetno inteligenco oziroma algoritme uvesti v čim več opravil.

Med najbolj ambiciozne projekte sodi robotski sodnik, ki bi lahko samostojno odločal v manjših sporih (do 7.000 evrov) in pomagal odpraviti sodne zaostanke. Za projekt, ki je šele v uvodni fazi, je zadolžen Ott Velsberg, vodja estonske službe za varovanje zasebnosti. Računalniški algoritem naj bi analiziral vse dokumente, ki so bili predloženi v sporu, in potem sprejel odločitev. Udeleženca se bosta seveda lahko pritožila in primer bo tedaj obravnaval človek, a ministrstvo za pravosodje upa, da bo sistem pospešil reševanje sporov.

Kot pojasnjuje Velsberg, si prizadevajo za čim vitkejšo državo. Da zmanjševanje števila javnih uslužbencev ne bi vplivalo na kakovost storitev, je nujna čim večja uporaba umetne inteligence. Po podatkih OECD v Estoniji v javnem sektorju dela 22 odstotkov ljudi, kar ustreza povprečju OECD in je odstotno točko več kot v Sloveniji.

Umetna inteligenca proti marihuani

Tožilstvo v Los Angelesu je lani začelo projekt sodelovanja z neprofitno organizacijo Code for America, v okviru katerega bodo pregledali 50.000 obsodb v zvezi z marihuano. Podoben projekt je pred tem v manjšem obsegu izvedel tudi San Francisco.

Leta 2016 so v Kaliforniji spremenili zakonodajo, ki po novem dovoljuje rekreativno uporabo marihuane nad 21. letom in omogoča izbris dosedanjih obsodb iz kazenske evidence. Code for America je razvil sistem Clear My Record, ki analizira stare obsodbe in preveri, katere izpolnjujejo pogoje za izbris. V San Franciscu so na tak način izbrisali 8.000 obsodb, v Los Angelesu pa jih bodo preverili 50.000. Ročni pregled toliko obsodb bi trajal leta, medtem ko Clear My Record odločitev sprejme povprečno v 12 sekundah. Ne gre namreč le za iskanje obsodb zaradi marihuane, temveč je treba preveriti tudi starost obsojenca, okoliščine in morebitna druga kazniva dejanja, saj se ne bodo izbrisale vse obsodbe.

Estonski projekt ni prvo spogledovanje z umetno inteligenco pri sojenju. Že leta 2016 so raziskovalci na University College London in univerzi v Sheffieldu izdelali program, ki je poskusil napovedati izide tožb. Ko je program prežvečil 584 primerov tožb zaradi kršitev človekovih pravic iz 3., 6. in 8. člena Evropske konvencije o varstvu človekovih pravic in temeljnih svoboščin (prepoved mučenja, pravica do poštenega sojenja in pravica do zasebnega življenja), je v 79 odstotkih podal pravilen izid. Premalo za kakršnokoli resno uporabo, a spodbudno za nadaljnje raziskave.

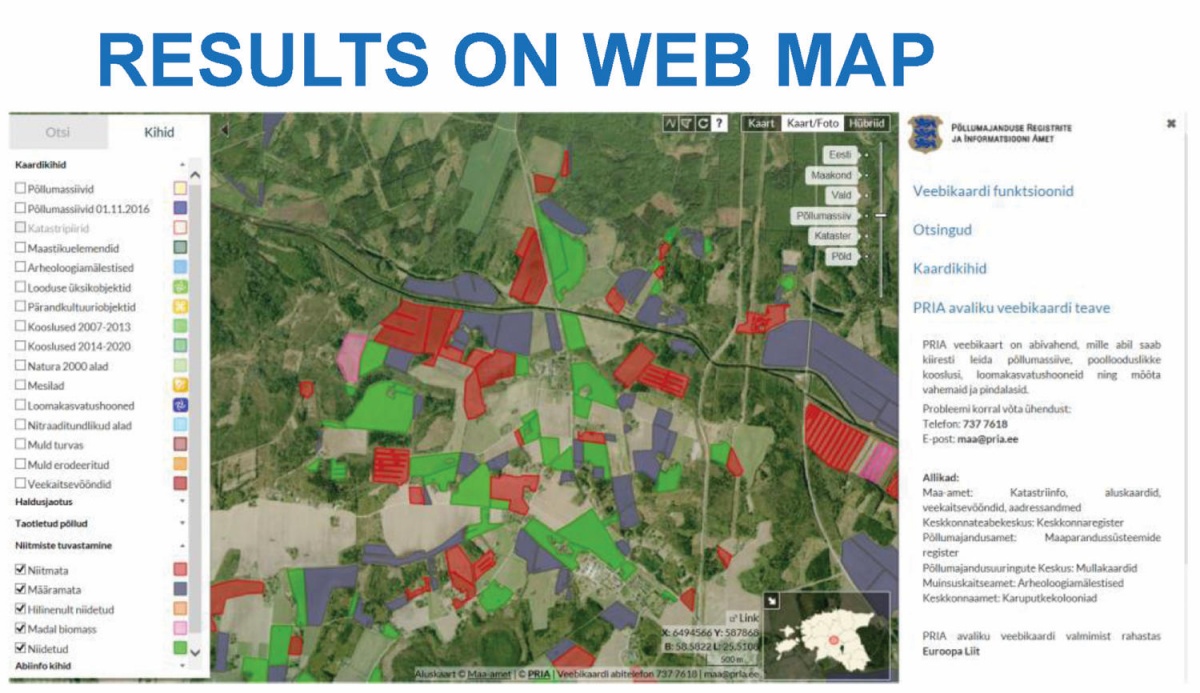

Umetna inteligenca v javnem sektorju

Estonci so umetni inteligenci prepustili vrsto opravil, ki so jih pred tem opravljali zaposleni v javnem sektorju. Velsberg je povedal, da gre že za 13 primerov. Včasih so morali inšpektorji sami preverjati, ali so kmetje resnično pokosili travnike, za katere so prejeli subvencijo. Zdaj uporabljajo algoritem Observatorija Tartu, ki se je z globokim učenjem naučil brati satelitske posnetke in preveriti, ali je trava pokošena. Agencija med majem in oktobrom vsak teden v sistem naloži nove posnetke, ki jih priskrbi Evropska vesoljska agencija. Algoritem v večini primerov sam ugotovi stanje travnikov, tako da je treba iti na lokacijo in jih v živo preveriti le v 5–6 odstotkih primerov. Leta 2017, ko so izvedli pilotno obratovanje, so privarčevali 650.000 evrov.

Razporeditev ocen tveganja na Strategic Subject Listu v Chicagu. Slika: Občina Chicago

Drugi primer je zavod za zaposlovanje, ki uporablja algoritme za uparjanje življenjepisov brezposelnih z izkazanimi potrebami delodajalcev. Rezultati kažejo, da po šestih mesecih delo obdrži 72 odstotkov iskalcev zaposlitve, ki jih je delodajalcem predlagal algoritem, v primerjavi z 58 odstotki pred uvedbo sistema. Toda treba je tudi upoštevati, da teh številk ne moremo primerjati v vakuumu, saj uvedba sistema sovpada z zadnjo konjunkturo, ki je seveda povečala potrebe po delavcih in stopnjo zaposlenosti.

V ZDA Agencija za varstvo okolja (EPA) uporablja umetno inteligenco za oceno, katere tovarne najverjetneje kršijo okoljske standarde in bi jih bilo treba preveriti.

Toži sam!

Algoritmi in avtomatika lahko koristijo tudi državljanom. Ni nujno, da je algoritemski le sodnik. V Veliki Britaniji je že nekaj časa na voljo spletni robotek DoNotPay v obliki aplikacije za Applov iOS ter kot spletna stran. Gre za izdelek Joshua Browderja z univerze Stanford, ki je bil sprva namenjen avtomatizaciji pritoževanja na globe zaradi nepravilnega parkiranja. Do danes se je DoNotPay naučil še nekaj drugih stvari, denimo pisanja pritožb zaradi izgubljene prtljage in zamud pri letalih, iskanja cenejših letalskih vozovnic in storniranja dražjih, ugovarjanja na bančne izpiske ter celo pisanja tožb v sporih manjših vrednosti. Seveda je prilagojen ameriškemu in britanskemu pravnemu sistemu, tako da je pri nas neuporaben, a kaže smer razvoja.

Estonija uporablja algoritme, ki s satelitskih posnetkov razberejo, ali so kmetijske površine ustrezno obdelane za izplačilo subvencij. Slika: pria.ee

Prihodnost

Že nekaterih enostavnih fizikalnih procesov ni mogoče deterministično napovedati, zato kaznivih dejanj v prihodnosti gotovo ne bomo mogli predvideti. Povsem realistično pa je pričakovati, da se bodo modeli za statistično predvidevanje izboljševali in vse uspešnejše predvidevali lokacije in osebe, povezane s kriminalom. Nič pa ni narobe, če umetna inteligenca analizira, kdo je požel polje, pokosil travo in kje bo jutri deževalo.

Bistveno kompleksnejši problem je uporaba algoritmov pri sojenju. Že vsak študent prava zna povedati, da se mora zakone brati v smislu, v katerem so bili napisani, ne po črki na papirju. Enako velja za sodbe in sankcije. Pri algoritemskem odločanju imamo dva velika problema. Prvi je, kako zagotoviti, da bo algoritem resnično upošteval vse okoliščine, le ne tistih, ki jih lahko kvantificiramo in suhoparno zapišemo v spis. Drugi je še resnejši – algoritmi, ki so črna škatla, v katero javnost nima vpogleda, so nesprejemljivi. Tudi pri odprtih algoritmih trčimo ob podoben legitimnosti problem kot pri e-volitvah, in sicer v kompleksnost in povprečnemu človeku nerazumljivost algoritma. Sicer se nam lahko zgodi nesprejemljiva razpršitev odgovornosti. Bi zaupali delo kontrole letenja umetni inteligenci, katere logike ne poznate?