Kako je Apple hotel vohljati po fotografijah

Avgusta je Apple dvignil veliko prahu z napovedjo, da bo v boju proti otroški pornografiji začel »skenirati« fotografije na telefonih. Strokovnjaki so kmalu razstavili Applov algoritem in pokazali, da je slabši od obstoječih rešitev. Apple je moral stopiti korak nazaj in septembra sporočiti, da za zdaj še ne bo vohljal po telefonih.

Moderna tehnologija za komuniciranje prek interneta ima problem. Uporabljamo jo ljudje, kar neobhodno pomeni, da jo bo neki manjši del ljudi poskušal izrabiti za nezakonita dejanja. Pravzaprav problem ni omejen na moderno tehnologijo, saj lahko tudi pištole, analogne kamere ali avtomobile enako zlorabimo.

Tim May je že leta 1988 skoval izraz štirje jezdeci infokalipse: terorizem, preprodaja mamil, pranje denarja in pedofilija. Boj proti omenjenim aktivnostim se večkrat uporablja kot paravan za povečevanje nadzora, omejevanje zasebnosti in krčenje svoboščin na internetu. Bruce Schneier je že leta 2005 zapisal, da lahko ob grožnji z njimi oblasti javnost prepričajo o sprejemu praktično kakršnihkoli ukrepov.

Boj proti pedofiliji

Internet je v resnici dal krila pedofilom, saj je po eni strani omogočil lažje razširjanje otroške pornografije kakor kadarkoli v zgodovini, po drugi strani pa je poenostavil prežanje na žrtve in njihovo zlorabo. Problema se zavedajo tudi organi pregona.

V ZDA že od leta 1984 obstaja Nacionalni center za pogrešane in zlorabljene otroke (NCMEC), ki med drugim vzdržuje velikansko zbirko posnetkov zlorabljenih otrok oziroma otroške pornografije (CSAM – child sexual abuse material). Vsi ponudniki storitev morajo po zakonu NCMEC prijaviti vse primere širjenja teh vsebin, ki jih zaznajo pri svojih storitvah. To se v praksi tudi izvaja, a ključna beseda je »zaznajo«. Če za problem na svojem dvorišču ne veš, potem ga pač ne moreš prijaviti.

V preteklem letu (2020) je NCMEC prejel 21,7 milijona prijav, kar je skoraj tretjino več kot leto pred tem. Levji delež prijav je prispeval Facebook, in sicer kar 20,3 milijona. Na drugem mestu je Google s 546.704 prijavami. Apple je lani prijavil vsega 265 incidentov. Težko je verjeti, da je Apple tega problema nima. Bistveno verjetneje se zdi, da nima mehanizmov, da bi ga zaznal.

Razlike so seveda tudi zaradi vrste storitev in tehnologije, ki jih podjetja ponujajo. Facebook je prvenstveno orodje za izmenjavo vsebin med uporabniki, Apple pa ponuja strojno opremo in arhitekturo. Apple rad poudarja svojo zavezanost zasebnosti, del katere je tudi šifriranje sporočil od pošiljatelja do prejemnika (end-to-end encryption) in šifriranje vsebine v oblaku iCloud. Za zadnjo Apple ključe sicer ima, a vsebine ne preverja brez sodnih odredb. Rezultat je očiten.

Apple ima problem

Da mora Apple nekaj storiti, je med strokovnjaki sprejeto že dlje časa. Že ko so leta 2019 Applovo direktorico za mednarodne preiskave in zaščito otrok Melisso Polinsky zasliševali pred neodvisno britansko komisijo IICSA (Independent Inquiry into Child Sexual Abuse), so lahko slišali, da je imel Apple v ekipi za preiskovanje posnetkov zlorabe otrok zaposlenih 6 (z besedo: šest) ljudi. Toda tehnologija je učinkovita, je trdila Melissa Polinsky. Podatki govorijo nasprotno.

Dve leti pozneje je zato Apple predstavil nov način boja proti zlorabam otrok, ki bi korenito spremenil zaveze podjetja o zasebnosti, spremenil milijone naprav v prisluškovalne naprave in – se vsemu skupaj odpovedal, še preden je sistem zaživel.

Pri zaznavanju otroške pornografije je treba rešiti problem, ki nastane zaradi nezakonitosti (in seveda široke družbene nesprejemljivosti, o čemer vlada konsenz) tega materiala. Ponudniki storitev ne morejo imeti zbirke otroške pornografije, s katero bi lahko primerjali vsebine, ki jih nalagajo uporabniki. Prav tako želimo karseda zmanjšati delo ljudi s tovrstni materialom, saj si nihče ne želi službe, kjer bi ure preverjal sumljive vsebine in iskal otroško pornografijo. Najlaže bi bilo to zaupati strojem.

Če se to sliši kot množično pregledovanje (sicer zasebne) komunikacije, je to zato, ker drži. To v resnici ni nič novega in marsikje smo sprejeli dejstvo, da našo komunikacijo analizirajo stroji. Gmail nam neželeno pošto iz elektronske pošte pobriše zato, ker njegovi roboti pač »preberejo« vso pošto. Pri elektronski pošti se nihče ne pretvarja, da je posredniki ne morejo brati, ker je šifrirana, niti tega ne pričakuje. Teže je pri storitvah, ki omogočajo šifriranje od pošiljatelja do prejemnika, saj tam ponudnik storitve oziroma infrastrukture ne pozna in ob primerni implementaciji nima možnosti videti vsebine komunikacije.

V praksi se tudi otroška pornografije išče zelo avtomatizirano. Možnosti so v principu štiri: kriptografska, algoritemsko zaznavanje, zaznavanje z umetno inteligenco in interpretacija z umetno inteligenco. Pri kriptografski metodi se izračuna zgoščena vrednost (npr. po algoritmu MD5 ali SHA1) posnetkov. Ta se primerja z zgoščeno vrednostjo poznanih nezakonitih datotek, ki jih imajo v svojih zbirkah organi pregona ali NCMEC. Če se vrednosti ujemata, gre z izjemno visoko stopnjo verjetnosti (mogoče so sicer kolizije, a v praksi zanemarljive) za otroško pornografijo. Problem te metode je neučinkovitost, saj so algoritmi za kriptografske zgoščene vrednosti dizajnirani tako, da se že minimalna sprememba vhodne datoteke izrazi v popolnoma drugačni zgoščeni vrednosti. To pomeni, da že sprememba ene pike v sliki ali samo ponovno kodiranje (denimo nov »Shrani kot«) spremeni zgoščeno vrednost.

Microsoftov PhotoDNA že deluje

Eden izmed uveljavljenih načinov za lovljenje otroške pornografije je Microsoftov sistem prepoznavanja fotografij PhotoDNA. Ta iz vsake fotografije izdela enolično zgoščeno vrednost (hash), ki jo potem primerja z znanimi vrednostmi za fotografije z otroško pornografijo. PhotoDNA je na voljo brezplačno in ga lahko uporabljajo ponudniki različnih storitev.

PhotoDNA uporablja algoritem za izdelavo zgoščene vrednosti (perceptual hash), ki je povezana s podobo na fotografiji. To pomeni, da imata zelo podobni fotografiji enako ali zelo podobno zgoščeno vrednost, zaradi česar je sistem odporen na manipulacije s fotografijami. Algoritem je namreč iskanje ravnotežja med specifičnostjo in selektivnostjo. PhotoDNA za zdaj teče na strežnikih in ni primeren za lokalno poganjanje, zato ga tudi iphone ne more uporabiti. PhotoDNA ne uporablja nevronskih mrež ali umetne inteligence, temveč klasične algoritme.

Applov nesojeni sistemi za analizo fotografij. Slika: Apple

Microsoftov sistem PhotoDNA se že široko uporablja za pregledovanje fotografij pri različnih storitvah. Slika: Microsoft

Algoritemsko zaznavanje (algorithmic/perceptual hash) je robustnejše. Fotografijo najprej korenito pomanjšamo, odstranimo in izpovprečimo barve, izračunamo bite in iz tega pridobimo zgoščeno vrednost. Te ne smemo zamenjevati s kriptografsko, ker je namen popolnoma drugačen. Tam želimo, da minimalne spremembe pomenijo veliko spremembo v zgoščeni vrednosti, tu pa ravno obratno, torej, da imajo podobne fotografije podobno zgoščeno vrednost. Ta metoda je odporna na spremembe velikosti fotografije, spreminjanje razmerja med širino in višino, barvne manipulacije itd. Izračunamo lahko oddaljenost med našo fotografijo in znanim nezakonitim posnetkom. Obstaja več algoritmov, a osnovni koncept je enak – gre za primerjavo delov fotografije, algoritem pa je znan in preverljiv. V obeh primerih pa iz zgoščene vrednosti ne moremo nazaj rekonstruirati posnetka.

Pri umetni inteligenci, ki se uporablja v implementaciji nevronskih mrež, izgubimo preglednost, saj natančen algoritem ni znan. Zaznavanje z umetno inteligenco (AI perceptual) je konceptualno sorodno algoritemskemu zaznavanju, saj gre ponovno za analizo posameznih delov fotografije in izračun zgoščene vrednosti, ki je podobna za podobne posnetke. Razlika je v tem, da to počne nevronska mreža, katere delovanje v podrobnosti ne poznamo – vemo le, kako je dizajnirana, na čem smo jo trenirali in kaj vrne kot rezultat.

Zadnja metoda, ki se imenuje interpretacija z umetno inteligenco, še ni dovolj razvita za praktično uporabo. Pri tej metodi bi nevronska mreža sama ugotovila, kaj je na posnetku.

Kaj je želel Apple

V začetku avgusta je Apple sporočil, da bo uvedel sistem za preganjanje otroške pornografije in zaščito otrok. Sestavljali bi ga dve komponenti: pregledovanje sporočil mladoletnih uporabnikov ter analiza vseh posnetkov v iCloudu vseh uporabnikov. Poglejmo naprej prvo.

Z algoritmom iz strojnega učenja bi Apple lokalno na napravi preverjal fotografije, ki jih pošiljajo in prejemajo mladoletni uporabniki v ZDA, če so del Family Accounta. Če bi sistem zaznal pornografsko (kakršnokoli, tudi legalno) vsebino, bi ukrepal. Kadar bi mlajši od 13 let poskušal poslati tako fotografijo, bi sistem to onemogočil in opozoril, da bodo ob vztrajanju, da se fotografija pošlje, obvestilo s fotografijo dobili tudi starši. Podobno bi ob prejeti fotografiji sistem opozoril, da bo ob ogledu poročilo romalo tudi k staršem. Kadar bi uporabnik zavrnil pošiljanje oziroma ogled fotografije, starši ne bi bil obveščeni. Za otroke med 13. in 17. letom bi v vseh primerih odpadlo obveščanje staršev, sistem pa bi jih še vedno opozarjal na neprimerno vsebino.

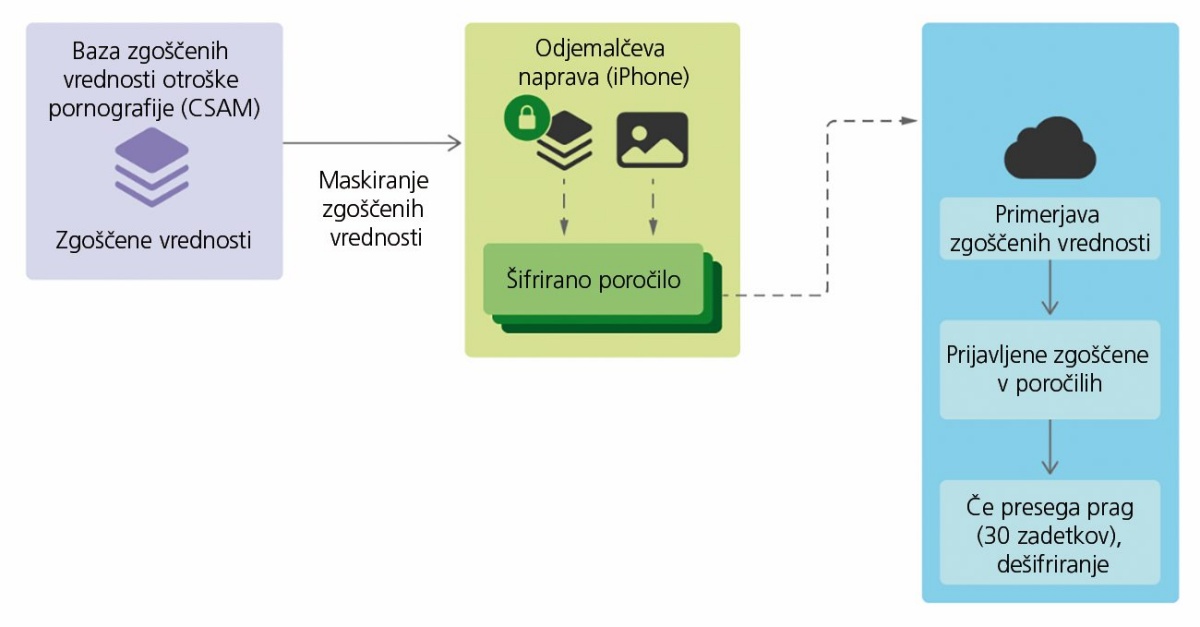

Bistveno bolj problematično pa je skeniranje vseh fotografij vseh uporabnikov. Applov sistem iOS bi z algoritmom NeuralHash lokalno preveril, ali fotografija ustreza kateri v zbirki znane otroške pornografije. Ko bi našel 30 takšnih zadetkov, bi telefon fotografije posredoval na Applove strežnike, kjer bi jih preverila usposobljena oseba in po potrebi prijavila organom pregona. Skeniranje bi potekalo na telefonu, preden bi se posnetki naložili v iCloud.

Applov sistem temelji na umetni inteligenci (AI perceptual hash), za kar v resnici ni nobenega pametnega razloga. S tem se namreč močno otežita analiza in pregled algoritma. Sistem deluje takole. Apple dobi od NCMEC in sorodnih organizacij zgoščene vrednosti znanih posnetkov otroške pornografije, ki jih v dodatno zamaskirani obliki shrani na telefonu vsakega uporabnika. NeuralHash potem na enak način analizira lokalne fotografije na telefonu, in če odkrije ujemanje, se pošljejo Applu. Številka 30 ni izbrana, ker bi bila majhna količina otroške pornografije dopustna, temveč zato, ker je sistem tehnično zastavljen tako, da je potrebnih več informacij za obnovitev šifrirnega ključa.

Kaj je šlo narobe

Le nekaj dni po predstavitvi algoritma je uporabnik GitHuba AsuharietYgvar sporočil, da mu je z vzvratnim inženiringom uspelo ugotoviti, kako točno deluje NeuralHash. Kmalu je neki drug uporabnik to znanje uporabil, da je demonstriral prvo kolizijo. Tako imenujemo odkritje dveh datotek, v tem primeru fotografij, ki sta različni, a vrneta enako zgoščeno vrednost. To je problematično, saj lahko na tak način uporabnika zasujemo z neškodljivimi fotografijami, ki pa jih sistem označi kot otroško pornografijo. Uporabnikov telefon bi jih potem posredoval Applu, ki sicer nima samodejnega dostopa do fotografij na telefonih.

Tudi če odmislimo kolizije, je NeuralHash slabo zasnovan. Raziskovalci so ugotovili, da algoritma ne zmotita spreminjanje velikosti fotografije in ponovno stiskanje, iz tira pa ga vrže prirezovanje (cropping) ali vrtenje. Če torej problematično fotografijo malenkostno obrežemo ali pa zasučemo, NeuralHash ne bo več ugotovil, da gre za isto fotografijo, kot je v zbirki NCMEC. Ne pozabimo, da NeuralHash ne razume vsebine na fotografijah, temveč jih le primerja z zgoščenimi vrednostmi v zbirki.

Konkretno povejmo, da NeuralHash spremeni velikost fotografij na 360 × 360 pik, nato pa jih obdela v nevronski mreži. Rezultat je 128-dimenzionalni vektor, ki ga potem projicira v 96-dimenzionalni prostor z množenjem z matriko dimenzij 128 × 96. Nato iz tega vektorja izračuna 96-bitno zgoščeno vrednost.

In pomanjkljiva izvedba je v resnici največji očitek NeuralHashu, ki je na noge dvignil varuhe zasebnosti in svoboščin. Gre namreč za sistem, ki predstavlja velikanski poseg v tajnost komunikacij, a je narejen tako površno, da ga je trivialno pretentati. V takem primeru se tehtanje med koristjo in tveganji prevesi na stran zadnjih.

To je ugotovil tudi Apple, ki so ga zasule pritožbe in pisma. Hitro je jel pojasnjevati, da je šlo za delovno različico algoritma in da bi bila končna bolj dodelana. Electronic Frontier Foundation je vseeno zbral več kot 25.000 podpisov proti novemu sistemu, druga peticija Fight for the Future in OpenMedia pa še dvakrat toliko. V odprtem pismu je več kot 90 organizacij pozvalo k ukinitvi programa.

Apple kaj dosti izbire ni imel in v začetku septembra je sporočil, da bo NeuralHash še malo počakal. Niso se izjasnili, ali bo načrt romal v koš ali zgolj na mizo k predelavam. Apple bo vsekakor moral biti zelo pazljiv, saj bo zdaj vanj uprtih še več oči in te bodo natančno premotrile naslednje poteze, ki se bodo zajedale v zasebnost.

Vse tri fotografije dajo isto zgoščeno vrednost z NeuralHash. Slika: anishathalye prek Githuba.

Situacija je zapletena, ker ni enostavnega leka. Štirje jezdeci seveda so problem, proti kateremu se je treba boriti, panaceje pa žal ni. Ukrepi morajo biti premišljeni. Iz preteklosti je znan soroden problem vgradnje stranskih vrat za prisluškovanje sicer šifrirani komunikaciji. Četudi bi bila namenjena izključno zakonitemu prisluškovanju po sodnih odredbah, je svet velik in poln ljudi z najrazličnejšimi nameni. Že sam obstoj stranskih vrat pomeni, da bi jih takoj začeli iskati hekerji in drugi kriminalci. Hkrati pa to daje ideje tudi drugim, recimo manj demokratičnim državam, da (legalno) pritisnejo na podjetje in zahtevajo izročanje podatkov.

Vse tovrstne sisteme je namreč trivialno predelati tako, da bi poleg otroške pornografije spremljali in izročali še kaj – ali pa vse. To so razlogi, da moramo ob omembi štirih jezdecev vedno zastriči z ušesi. Za plemenitimi cilji in visokoletečimi besedami se namreč lahko namerno ali nenamerno skrivajo velike luknje.

Evropska zakonodaja pregledovanje dovoljuje

Evropski parlament je 6. julija letos sprejel dopolnila pri odstopu od direktive o zasebnosti (ePrivacy derogation), ki začasno dovoljujejo množično strojno pregledovanje vsebine spletne komunikacije, če gre za boj proti zlorabi otrok. V začetku leta je začela veljati spremenjena definicija elektronskih komunikacij, zaradi katere se za orodja za spletno komuniciranje uporablja direktiva o zasebnosti (ePrivacy) in ne več GDPR. Ta ima vključene izjeme za boj proti zlorabi otrok, prvotna direktiva pa ne. Brez julija sprejete dopolnitve, ki bo veljala tri leta, podjetja ne bi mogla samodejno filtrirati in odstranjevati spornih posnetkov. Tako bi, na primer, Facebook izgubil mogoča samodejna brisanja očitno nezakonitih vsebin.