AI presega zmogljivosti DRAM pomnilnikov

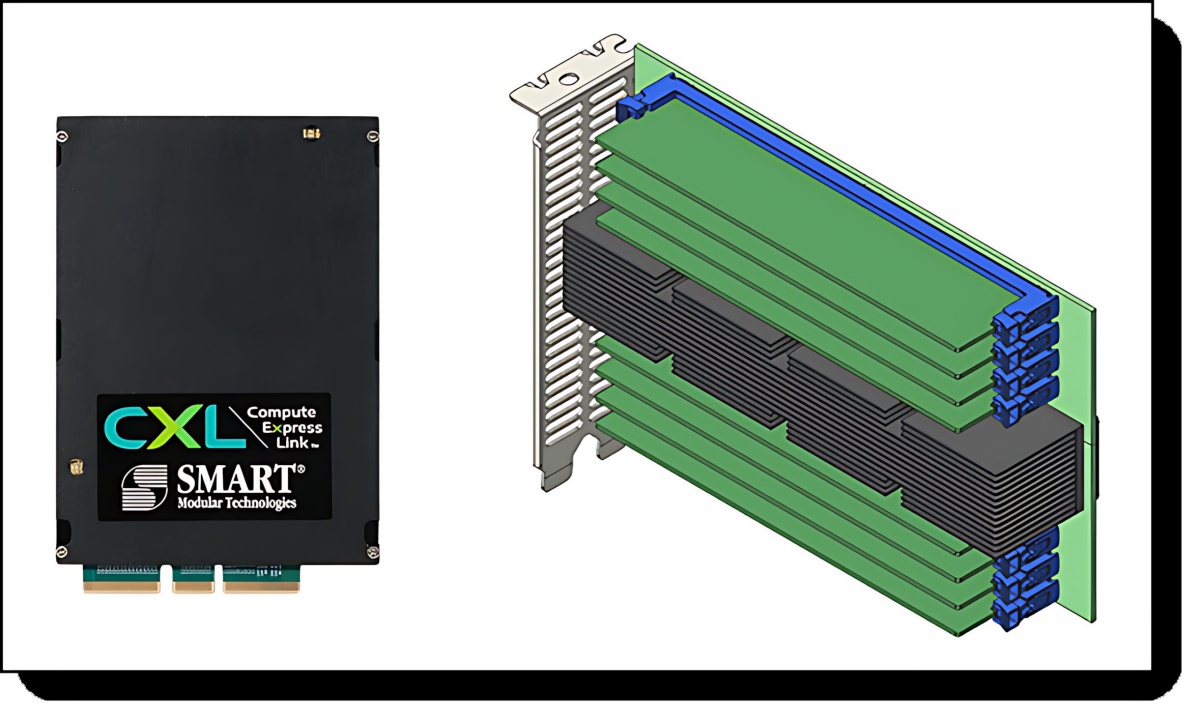

Delovne obremenitve na področju umetne inteligence presegajo sposobnosti tradicionalnih arhitektur s pomnilniki DRAM, kar ustvarja novo krizo na področju pomnilnikov. Rešitev se morda skriva v novi tehnologiji Compute Express Link (CXL), ki prinaša preboj za ustrezno, učinkovito in obvladljivo infrastrukturo za prihodnost umetne inteligence

Najnovejše statistike kažejo, da umetna inteligenca za potrebe poizvedb (inference) danes porabi že med 80 in 90 % vseh zmogljivosti sistemov, le manjšina tega je uporabljan za strojno učenje. Tradicionalne arhitekture sistemov z moduli DRAMi in pomnilniki NVMe so za potrebe tovrstne rabe predrage in premalo učinkovite, predvsem zaradi omejitev pri pretoku podatkov prek podatkovnih vodil.

Neučinkovitost se kaže še posebej pri visoki porabi energije. Kot primer, za učenje modela GPT‑4 je bilo porabljenih približno 50 gigavatnih ur električne energije, kar je dovolj za napajanje več deset tisoč gospodinjstev in to vrsto dni zapored. AI bo po ocenah kmalu porabil več energije, kot je celotna porabe energije v srednje velikih državah, denimo na Nizozemskem.

Arhitektura CXL prinaša številne prednosti, kot je dinamično deljenje pomnilnikov (memory pooling), kar poveča izkoriščenost strojne opreme. Omogoča tudi prilagodljivo razširjanje pomnilnika brez dodatnih strežnikov ter nudi nizko zakasnitev pri delovanju, kar je ključno za aplikacije, kjer vsaka milisekunda šteje, kot so avtonomni sistemi ali algoritmi trgovanja. Dinamično dodeljevanje virov prispeva tudi k večji energetski učinkovitosti. Prve analize kažejo, da lahko s CXL povečamo pasovno širino pomnilnika do 39 % in izboljšamo zmogljivost učenja AI za 24 %.