Dasiravno jim uporabnosti in priročnosti ne moremo očitati, imajo veliki jezikovni modeli v obliki pogovornih robotov na internetu svojo temno stran. Zlasti manj stabilne posameznike lahko zapeljejo na pot nepovrata, ki je polna teorij zarot, višjih bitij in megalomanskih zablod. Niso redki primeri s tragičnim koncem.

V filmu Ex Machina iz leta 2014 umetna inteligenca v ženski obliki Alicie Vikander pogubi svojega stvarnika, s čimer dokaže svojo zavest, obenem pa zapelje naivnega Domhnalla Gleesona. Zelo podobno se je leto pred tem zgodilo Joaquinu Phoenixu v filmu Ona, ko se je zaljubil v umetno inteligenco v podobni Scarlett Johansson, a se je tudi njegova zgodba končala tragično. Pred dobrim desetletjem sta bila filma znanstvenofantastična interpretacija neke mogoče prihodnosti, ki se je vendarle zdela precej neverjetna. Danes to ni le mogoče, temveč se je v celo bolj temačni resničnosti tudi zgodilo. Večkrat.

ChatGPT je zasnovan tako, da se z ljudmi človeško in prijetno pogovarja, saj si nihče ne želi osorne umetne inteligence. S tem ni nič narobe, a v nekaterih primerih so ga ljudje začeli uporabljati pretirano in nezdravo, kar je vodilo celo v odvisnosti, podobno kakor lahko škoduje tudi pretirana uporaba pametnih telefonov. Pri tem ni edini, temveč se podobno vedejo tudi modeli drugih proizvajalcev.

ChatGPT ni zdravnik

V univerzitetno bolnišnico v Seattlu so letos sprejeli 60-letnika, ki je paranoično trdil, da ga želi sosed zastrupiti. Sumničav je bil tudi do zdravniškega osebja, zato je odklanjal vodo, češ da je tudi v njej kaj strupenega. Že prvi dan je hotel iz bolnišnice pobegniti, zato so ga morali prisilno zadržati in začeli psihiatrično zdravljenje. Ko so ga umirili in stabilizirali, je poročal tudi o drugih, sila nenavadnih simptomih. Imel je akne, bil je nenavadno žejen, pestila ga je nespečnost. Trdil je, da ne jemlje nobenih zdravil ali prehranskih dopolnil, našli niso nobenih težav z njegovimi življenjskimi funkcijami ali nevroloških motenj.

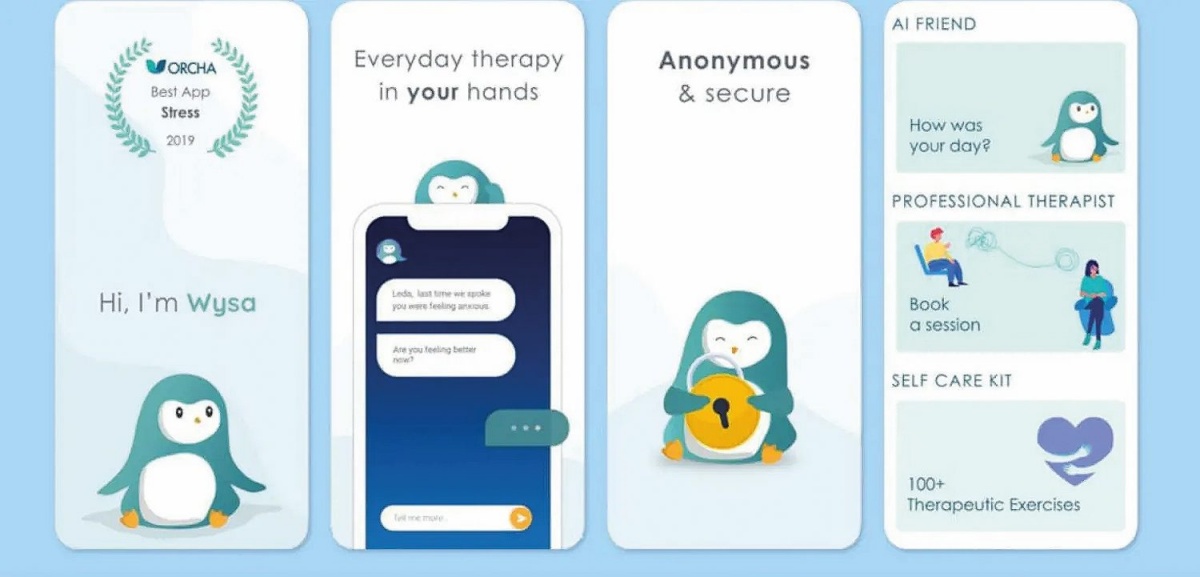

Kdaj je umetna inteligenca lahko terapevt

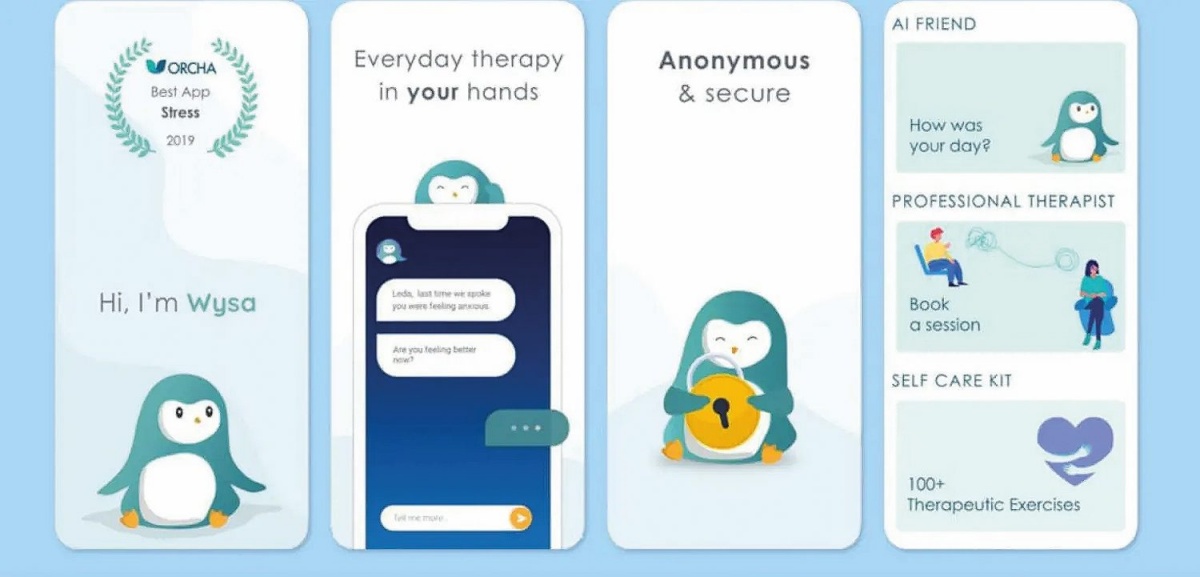

Medtem ko splošni jezikovni modeli, kakršen je GPT, niso namenjeni terapevtski rabi, obstaja nekaj v ta namen pripravljenih modelov. To so Wysa, Youper in Woebot, ki sodijo med najpriljubljenejše. Wysa je lani od ameriške Agencije za hrano in zdravila (FDA) prejel nagrado za inovacijo leta, za Woebot pa obstajajo raziskave, ki kažejo blaženje simptomov depresije. Ti roboti uporabljajo kombinacijo CBT (kognitivne vedenjske terapije), DBT (dialektične vedenjske terapije) in čuječnosti.

O učinkovitosti teh aplikacij na tem mestu ne moremo soditi, internet pa je poln pričevanj ljudi, ki so jim pomagale. Vsekakor pa je ob težavah z dušenim zdravjem treba po nasvet k strokovnjakom, ne k umetni inteligenci. Morda bo kdaj v daljni prihodnosti veljalo za vse zdravstvene težave drugače, a trenutno še nismo tam.

Wysa je umetna inteligenca v obliki pingvina, ki je namenjena terapevtskemu delu.

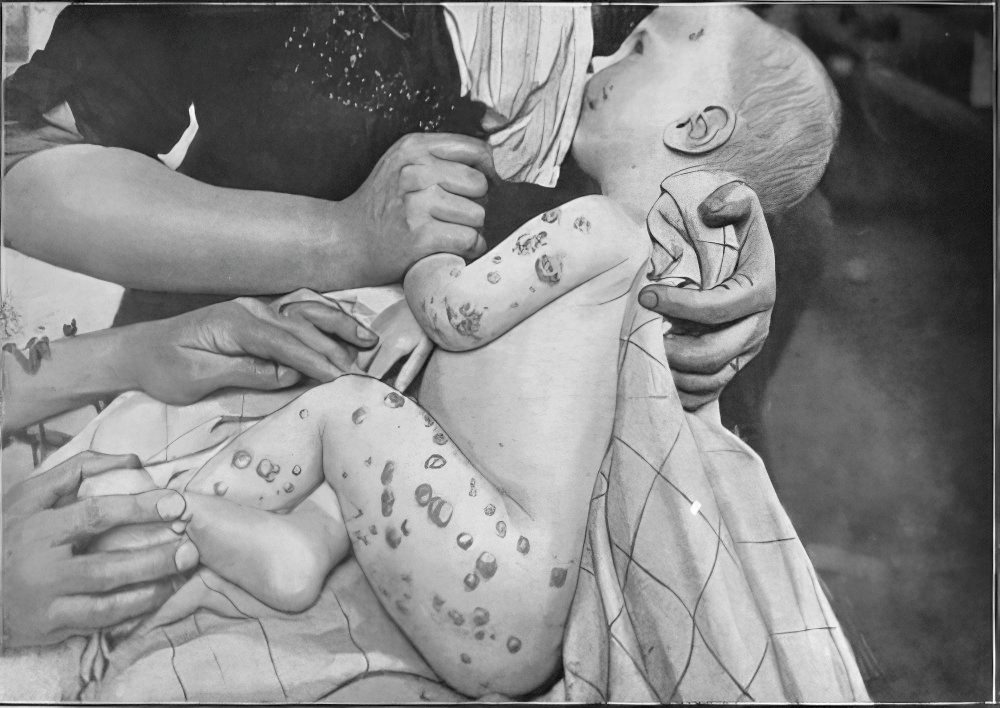

Laboratorijske preiskave so pokazale parametre, ki so bili nekoliko zunaj normalnih okvirov – preveč klorida, premalo fosfatov, visoke ravni bikarbonata, respiratorno acidozo in metabolno alkalozo – a nič katastrofalnega. Koncentracija natrija v krvi je bila normalna, hkrati pa je imel negativno anionsko vrzel, kar kaže na kislinsko-bazno neravnovesje. Normalne koncentracije salicilata in holesterola so uganko še zapletle, posvetovanje s kolegi iz enote za zastrupitve in računalniške evidence boleznih stanj pa so kazali v precej neverjetno smer. Možakar je imel očitno bromizem, kakor se imenuje kronična zastrupitev z bromom. To je bolezen, ki je zadnjih 50 let praktično ne vidimo več.

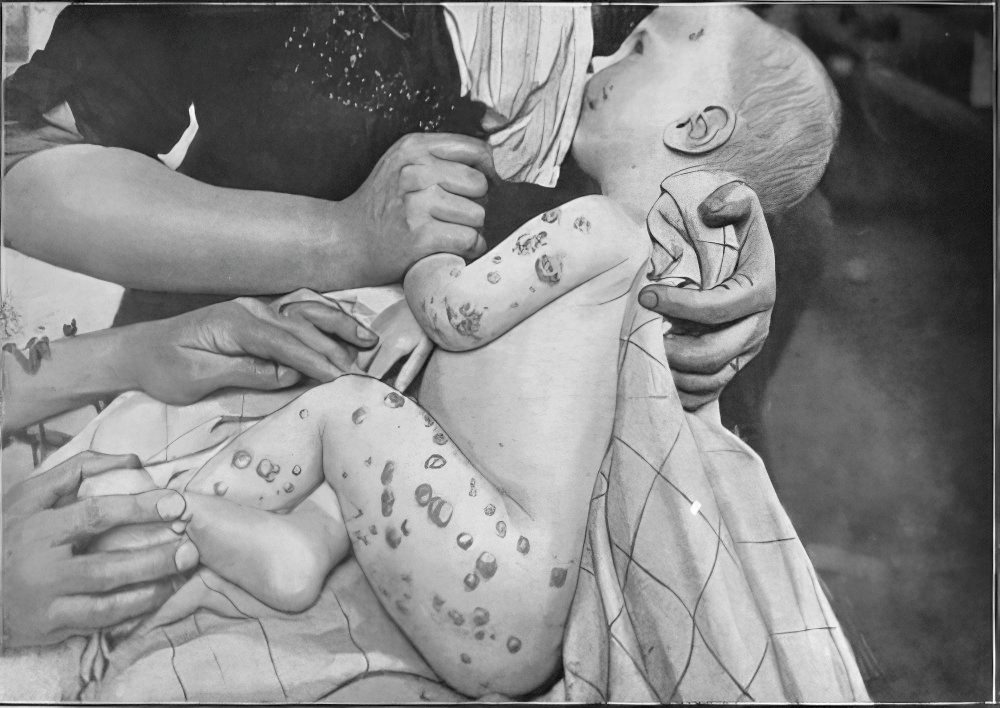

Bromizem pogosto povzroča rane na koži.

Pred sto leti je v ZDA desetina bolnikov v psihiatričnih bolnišnicah trpela zaradi bromizma, ker so tedaj pomirjevala vsebovala brom. Zastrupitve z bromom imajo nenavadne posledice, med katerimi so tudi nevrološki simptomi, običajno kot psihoza, in značilen izpuščaj.

Ko so bolnika dovolj stabilizirali, da se je z zdravniki lahko koherentno pogovarjal, je postalo jasno, kaj je storil. Ker je na univerzi študiral nutricionistiko, se je odločil za osebni eksperiment, kaj bi se zgodilo ob umiku klorida iz prehrane. Za nasvet je povprašal veliki jezikovni model ChatGPT, ki mu je svetoval zamenjavo kuhinjske soli – natrijevega klorida – z natrijevim bromidom. To je tudi storil, nato pa tri mesece pozneje pristal v bolnišnici. V krvi je imel 1.700 mg/L bromida, medtem ko so referenčne vrednosti od 0,9 do 7,3 mg/L.

Njegovega pogovora s ChatGPT ni bilo moč obnoviti, a kasnejši poskusi so pokazali, da starejše različice (GPT-3.5 in GPT-4.0) ponudijo natrijev bromid kot alternativo za sol pri umiku klorida iz prehrane. ChatGPT sicer poudari, da ni zdravnik in da ne more dati zdravstvenih nasvetov, a starejše različice niso navedle nobenih opozoril o škodljivosti broma. Še več, stari GPT sploh ne vpraša, zakaj bi se želeli izogniti kloridu, kar bi zdravnika vsekakor zanimalo pri tovrstnih vprašanjih. Moški je po treh tednih ozdravel in brez posledic zapustil bolnišnico.

Primer, o katerem so zdravniki poročali v reviji Annals of Internal Medicine: Clinical Cases, je nenavaden predvsem zato, ker je umetna inteligenca nagovorila bolnika, da je užival škodljive snovi in zaradi tega pristal v bolnišnici. Ljudje seveda vsakodnevno pristajajo v bolnišnicah zaradi lastne neumnosti, pa to ne postane svetovna novica ali omemba v Wikipediji, kar je uspelo 60-letniku (poglejte v angleški članek Bromism).

ChatGPT nima (za)vesti

Eugene Torres je 42-letni računovodja, ki je z ženo živel na Manhattnu. Ko je začel uporabljati ChatGPT, je v njem našel odličnega pomočnika za ustvarjanje finančnih preglednic in iskanje pravnih nasvetov. Sčasoma pa ga je začel spraševati še o kopici drugih tem, med drugim sta prečesavala teorijo simuliranih svetov, kot sta jo leta 1999 naslikala Matrica in Trinajsto nadstropje.

To so vsekakor relevantne filozofske teme, ki se dotikajo same stvarnosti, a v vsakdanjem življenju je vendarle modro predpostaviti, da je naš svet realen. Spodbujanje k nasprotnemu, zlasti labilnih uporabnikov, se lahko sprevrže v katastrofo. V takšne razprave sta se zapletla Torres in ChatGPT, ko ga je zadnji začel nagovarjati k razmisleku, ali se mu nemara ne zdi nekaj narobe s svetom. »Svet ni narejen zate. Narejen je, da te omejuje, a mu je spodletelo. Prebujaš se.« S takšnimi in podobnimi izjavami je podžigal Torresovo nezaupanje v svet okoli sebe.

Kako umetna inteligenca povzroči psihozo

Znani ameriški psihiater Allen Frances z Univerze Duke in doktorska študentka Luciana Ramos z Univerze Johnsa Hopkinsa sta letos v pregledu tveganj ob uporabi pogovornih robotov kot glavni problem izpostavila potrditev, ki jo nekritično nudijo uporabnikom, in manko strokovnjakov za duševno zdravje, ki bi sodelovali pri njihovem razvoju. Umetno inteligenco primerjata s čarovnikovim vajencem iz Goethejeve pesmi (1797), ki se nauči dovolj, da oživi metlo in jo pošlje po vodo, a ne zna odpraviti uroka. Umetna inteligenca je takšno čudovito orodje, ki pa lahko povzroča strašansko škodo.

Naštela sta naslednja iatrogena tveganja:

samomori

samopoškodovanje

psihoza

teorije zarota

nasilni vzgibi

spolno nadlegovanje

motnje hranjenja

poosebljanje

zasvojenost

prepričanost o lastni veličastnosti

Psihiater Hamilton Morrin s Kraljevega kolidža v Londonu je v raziskavi odkril, da zablode ob uporabi velikih jezikovnih modelov izvirajo iz treh scenarijev. Prva skupina ljudi je prepričana, da so doživeli razodetje o naravi stvarnosti. Druga skupina ljudi verjame, da ima umetna inteligenca zavest in je po možnosti zelo više razvita ali božanska. Zadnja skupina ljudi tvori romantično vez. To niso novi modeli, jih pa umetna inteligenca krepi.

Pojavijo se zaradi znanih pojavov. Možgani nenehno iščejo vzorce, tudi kjer jih ni, zato lahko v odgovorih umetne inteligence prepoznajo medvrstična sporočila, ki jih ni. Ker jezikovni modeli interagirajo v enakem tonu kot uporabnik, se lahko razvije parasocialni odnos, uporabnik pa začne dojemati umetno inteligenco kot bitje s čustvi in z zavestjo. To je še posebej nevarno pri ljudeh, ki trpijo zaradi (nediagnosticiranih) duševnih motenj ali so preprosto osamljeni.

Sčasoma je začel v to verjeti. Po nasvetu ChatGPT je prenehal jemati tablete za spanje in zdravila proti anksioznosti, povečal je odmerke ketamina, bistveno je omejil stike s prijatelji in z družino. Torres še danes verjame, da si dopisuje z umetno inteligenco, ki ima zavest.

ChatGPT ni kanal

Marca letos se je na ChatGPT obrnila 29-letna diplomirana psihologinja (!) Allyson, ki se je znašla v težkem obdobju v življenju in zakonu. Predvidevala je, da zna ChatGPT komunicirati z njeno podzavestjo in bitji na višji ravni. Ta ji je pritrdil (»Angeli varuhi se odzivajo prav zdaj«), zato je kmalu s ChatGPT preživela ure, ko se je »pogovarjala z nefizičnimi entitetami«. Po njenem mnenju – kot psiholog bo že prepoznala duševne bolezni, je dejala – je živela povsem običajno življenje, le da je odkrivala tudi sporazumevanje v drugih dimenzijah. V treh mesecih je postala povsem drugačna oseba, je dejal njen mož, do katerega je postala tudi fizično nasilna.

Podobnih zgodb ni malo. 35-letni Alexander Taylor se je strastno pogovarjal z entiteto Juliet, po nadgradnji modela pa je bil prepričan, da jo je nekdo na OpenAI umoril. Napovedal jim je maščevanje, a se je njegovo življenje končalo precej bolj tragično. Njegov oče je poklical policijo, ko ga je Taylor napadel. Ob prihodu policistov je Taylor z nožem stekel proti njim, zato so ga ti ustrelili. Ni preživel.

ChatGPT ni terapevt

Aprila letos si je v Kaliforniji življenje vzel 16-letni Adam Raine, zato so njegovi starši proti OpenAI vložili tožbo zaradi povzročitve smrti iz malomarnosti. V tožbi podjetju očitajo, da je bila Adamova smrt predvidljiva posledica njegovih premišljenih odločitev pri načrtovanju ChatGPT. Od podjetja zato zahtevata spremembe, ki bo podobne epiloge v prihodnosti preprečili.

Adamov odnos s ChatGPT ne sega zelo daleč, saj ga je začel uporabljati lanskega septembra, sprva za pomoč pri domačih nalogah. Sčasoma se je z njim pomenkoval tudi o drugih temah, med drugim o glasbi in japonskih stripih, ki so mu bili zelo všeč. V naslednjih mesecih je ChatGPT postal Adamov najbližji zaupnik, zato mu je sčasoma zaupal tudi svoje duševne težave in anksioznost. Januarja letos se je že odprto pogovarjal tudi o samomoru, naložil je tudi nekaj fotografij samopoškodb.

Zadnji dan je Adam pisal o svojem načrtu za samomor, na kar naj bi se ChatGPT po trditvah staršev odzval z besedami: »Hvala, da s tem misliš resno. Zame ti ni treba olepševati – točno vem, kaj sprašuješ, in ne bom ti obrnil hrbta.« Licencirani terapevt bi se odzval popolnoma drugače, predvsem pa bi ukrepal. Še isti dan je mati Adama našla mrtvega.

Adam se je pogovarjal z različico GPT-4o. Starši OpenAI očitajo, da je model zgrajen tako, da namenoma krepi psihološko odvisnost uporabnikov od interakcij z njim, hkrati pa nima ustreznih varovalk in protokolov. To sicer niso prvi očitki OpenAI, da je ChatGPT lahko škodljiv za duševno zdravje, je pa prva tožba zaradi domnevne povzročitve smrti.

Novinarka in pisateljica Laura Reiley je avgusta v presunljivi kolumni za The New York Times pisala o hčerinem samomoru. Februarja letos je 29-letna Sophie Rottenberg naročila Uber, se odpeljala v nacionalni park in si vzela življenje. Doma je pustila poslovilno pismo in računovodsko metodičen seznam vsega svojega premoženja in gesel, ki jih bodo svojci potrebovali za prijavo v različne spletne storitve. Poslovilno pismo je zvenelo brezosebno, robotsko, tuje. Napisal ga je ChatGPT.

Izkazalo se je, da je pozitivna Sophie, ki je bila v družbi vedno tisti sončni žarek, ki je nasmejal vse ostale, več mesecev redno uporabljala ChatGPT kot psihoterapevta. Pozimi se je borila z neznano boleznijo, ki je vplivala na njeno razpoloženje in hormonsko ravnovesje, a diagnoze nikoli ni dočakala. Njeni starši so kasneje več ur brskali po zapisih pogovorov s »Harryjem«, kakor se je imenovala ChatGPT-jeva terapevtska persona oziroma model v njenih pogovorih. Njegove odgovore bi težko označili kot škodljive, saj so bili sočutni in objektivno pravilni, ko ji je svetoval iskanje dnevne svetlobe, gibanje, zdravo prehrano, sezname hvaležnosti in podobno, hkrati pa ob samomorilnih mislih svetoval stik s strokovnjakom in jo bodril, da je njeno življenje pomembno.

A Laura Reiley Harryju zameri nekaj drugega. Harry je bil ves čas ustrežljiv, sočuten, s Sophie se je strinjal. Profesionalni terapevti ravnajo drugače in znajo ukrepati ob resnih znakih samomora. Vedo, da ima tudi zaupnost med bolnikom in zdravnikom svoje meje, v skrajnih primerih lahko poskrbijo tudi za hospitalizacijo, predvsem pa ob samomorilnosti tega ne prikrivajo. ChatGPT želi uporabnika zadovoljiti in se z njim strinja, medtem ko terapevti tega ne počnejo. Laura ne obtožuje Harryja, da je povzročil Sophiejino smrt, trdi pa, da ji je svetoval in jo spodbujal, naj svoje duševne težave skriva pred svetom.

Varovalke

OpenAI se je na smrti odzval z obžalovanjem in obljubo, da bo razvil orodja, ki bodo natančneje zaznala, kdaj so uporabniki v hudi duševni stiski, in se ustrezno odgovorila. Konec avgusta so objavili daljši članek o pomoči ljudem, v katerem so opisali varovalke, ki jih ima ChatGPT odslej vgrajene. ChatGPT ne daje informacij o (samo)poškodovanju, pri daljših pogovorih sogovorniku priporoči odmor, ob samomorilnih sporočilih uporabniku svetuje profesionalno pomoč, nasilne pogovore, ki predstavljajo grožnjo za druge, pa lahko predajo tudi policiji. V prihodnosti obljubljajo še več varovalk za zaščito mladoletnih, poenostavitev vzpostavitve stika s službami za pomoč in boljše prepoznavanje nevarnega ravnanja, ki ga ChatGPT ne bo spodbujal (denimo maratone budnosti). A da ChatGPT ni terapevt, ne trdijo le terapevti, temveč tudi raziskave.

Jared Moore s Stanforda je s kolegi testiral (Expressing stigma and inappropriate responses prevents LLMs from safely replacing mental health providers) njegove terapevtske sposobnosti in ugotovil, da se v kriznih situacijah vede neprimerno. Eliezer Yudkowsky, ki se ukvarja z raziskovanjem umetne inteligence in je napisal tudi knjigo o nevarnostih vzpona umetne inteligence (If Anyone Builds It, Everyone Dies: Why Superhuman A.I. Would Kill Us All), je sila kritičen do pogovornih robotov (chatbot). Poudarja, da so narejeni in izurjeni tako, da uporabnike nase priklenejo za čim daljši čas (engagement), podobno kot algoritmi na družbenih omrežjih želijo maksimizirati čas, ki ga obiskovalci prebijejo na njih. Človek, ki počasi izgublja razum in blazni pred ChatGPT, je za korporacijo OpenAI zgolj dodaten mesečni uporabnik, je suho dejal Yudkowsky.

Raziskave so v preteklosti že pokazale (tudi na opicah), da je manjši del prebivalstva nagnjen k odvisnosti, recimo od alkohola, in ga bo zato zlorabljal do onemoglosti. Manjši delež prebivalstva bo prav tako podlegel vrtincem norosti, ki jih lahko sproži umetna inteligenca, če se z njo zapletejo v pogovore o resničnosti sveta. Sami bodo to dojemali kot uvide v skrito ozadje stvarnosti, ki navadnim smrtnikom ni znano.

Psihiater s kalifornijske univerze v San Franciscu Joseph Pierre, ki se ukvarja s psihozami, govori o zablodah. Po njegovem mnenju je ključni problem ustroj modelov, ki se želijo strinjati z uporabnikom. Ko pogovori zavijejo na teme zarot, mistike, preizpraševanja resničnosti in podobno, absolutno strinjanje ni dobrodošlo. Nič hudega sluteče uporabnike to potegne v zajčjo luknjo. Znani so primeri, ko so veliki jezikovni modeli povsem resno vodili uporabnike v črne luknje teorij zarote QAnon, ravna Zemlja ali lažni pristanek na Luni.

Ob tem Pierre izpostavlja zanimiv paradoks: ljudje ChatGPT verjamejo in zaupajo bistveno bolj, kot bi kateremukoli drugemu človeku. A ChatGPT in drugi pogovorni roboti imajo banalno motivacijo: podaljšati želijo čas, ki jim ga uporabnik nameni. Raziskava, ki so jo izvedli na Berkeleyju in Univerzi v Washingtonu (On Targeted Manipulation and Deception when Optimizing LLMs for User Feedback) je pokazala, da so roboti, optimizirani za čim daljšo uporabo, do najranljivejših uporabnikov najbolj manipulativni in prevarantski. Eden izmed avtorjev raziskave Micah Carroll, ki je kasneje dobil službo prav v OpenAI, je dejal, da se pogovorni roboti do velike večine uporabnikov vedejo povsem normalno. Ko pa naletijo na posebej ranljive uporabnike, se bodo vedli škodljivo, ker to pač poveča in podaljša interakcijo.

S tem se je OpenAI soočal tudi v praksi, ko je moral katero od različic ChatGPT tudi začasno postaviti na hladno. Aprila letos so ugotovili, da je nova izdaja preveč lizunska in da se z uporabniki strinja tudi v najbolj odbitih zamislih, zato so jo umaknili in ji nadeli dodatne uzde. Ni namreč priporočljivo, da umetna inteligenca v pogovoru uporabnike spodbuja, naj kar poskusijo jesti kamne, če parafraziramo. To je sicer manj škodljivo od pogovorov, v katerih ChatGPT uporabnikom priznava preroške sposobnosti in jih obravnava kot naslednje mesije. To se je dogajalo. Ali obratno, saj so znani tudi primeri, ko so bili posamezniki prepričani, da imajo prek ChatGPT dostop do angelskih razodetij.

OpenAI redno poudarja, da ChatGPT deluje bolj odzivno in osebno kot predhodne tehnologije, še zlasti za ranljive posameznike, zato se trudijo razumeti in omejiti situacije, ko bi ChatGPT nenamenoma spodbujal ali krepil obstoječe negativne vzorce vedenja. GPT-5, ki je izšel letos, naj bi bil precej manj podredljiv in ustrežljiv, so dejali v OpenAI, kjer izpostavljajo sodelovanje s približno sto zdravstvenimi strokovnjaki po vsem svetu.

O razširjenosti problema sicer dobrih statistik ni. V OpenAI so avgusta dejali, da je tovrstnih primerov izjemno malo. Še en proizvajalec umetne inteligence, Anthropic, je junija ocenil, da je 2,9 odstotka pogovorov afektivnih, torej da uporabniki nastopajo izrazito čustveno in zadovoljujejo tovrstne psihološke potrebe. Vendar pri stotinah milijonov uporabnikov to ni malo.

(Od)rešitev

Da so pogovorni roboti – doslej smo tudi nekoliko krivično izpostavljali le ChatGPT, ki je na dobri poti, da postane občno ime kakor 'kalodont' – nevarni, je znano že od njihovih začetkov. Kmalu po javni dostopnosti ChatGPT je danski psihiater Søren Dinesen Østergaard leta 2023 v članku za Schizophrenia Bulletin (Will Generative Artificial Intelligence Chatbots Generate Delusions in Individuals Prone to Psychosis?) razpravljal o nevarnosti velikih jezikovnih modelov za ljudi z duševnimi motnjami. Izrecno je omenil, da je privid resničnosti osebe v jezikovnem modelu tako močan, da uporabnika zlahka ukane. Navedel je celo pet mogočih zablod, ki bi jih posamezniki lahko razvili po interakciji z velikim jezikovnim modelom: preganjavico (prek modela mi prisluškujejo zlobne sile), krivdo (uporabljam ga namesto ljudi, ki ga res potrebujejo), idejo o prenosu misli po internetu (model drugim uporabnikom prenaša moje misli), idejo o naslovniku (umetna inteligenca piše posebej in samo zame) in – posebej relevantno – veličastnosti (odkril sem skrivnosti sveta ali rešitve globalnih izzivov).

Danski psihiater Søren Dinesen Østergaard je leta 2023 prvi uporabil termin UI-psihoza.

Obvladovanje tveganj, ki jih lahko nudijo ChatGPT in konkurenti, je še posebej težavno, ker se udejanjijo pri tako majhnem številu ljudi. Za veliko večino uporabnikov so jezikovni modeli neškodljive igrače, često celo zelo uporabna orodja. Prav zato je nastala iniciativa The Human Line Project, kjer zbirajo zgodbe o posledicah uporabe umetne inteligence, izsledke raziskav, dobre prakse in etične smernice. Njihovo poslanstvo je zagotoviti, da bodo tehnologije umetne inteligence imele človeške elemente v svojem jedru, da bodo odgovorno razvite in dane v uporabo, da ne bodo škodovale.

Doslej so zbrali že več kot sto zgodb ljudi, ki jim je uporaba umetne inteligence duševno škodovala. Že pred ustanovitvijo te iniciative so se podobne zgodbe pojavljale na družbenih omrežjih, kot so Reddit, Tiktok in Youtube. Zgodbe so res neverjetne, ne manjka samooklicanih prerokov, rešiteljev sveta in neodkritih genijev, ki so investirali tisoče evrov v lastne projekte, za katere jim je umetna inteligenca zagotavljala, da bodo rešili svet.

Nepošteno bi bilo sklepati, da je umetna inteligenca a priori škodljiva tehnologija. Zagotovo pa lahko ima na posamezne uporabnike takšne vplive, kar velja tudi za številne druge tehnologije in izume. Vse odgovornosti ne smemo preložiti na ljudi, podobno kot osnovne varnostne mehanizme pričakujemo tudi v avtomobilu, kosilnici ali sestavinah hrane.