Tudi pri nas smo super

Dvakrat na leto izide posodobljena lestvica 500 najhitrejših superračunalnikov na svetu, na kateri žal ni nobenega slovenskega predstavnika. A to ne pomeni, da v Sloveniji sploh nimamo ali ne uporabljamo superračunalnikov. Imamo jih kar nekaj in z njimi večinoma znanstveniki rešujejo vrsto zanimivih problemov, le razdrobljeni so po vsej državi. Ogledali smo si, kako so zgrajeni superračunalniki in katere imamo v Sloveniji.

Za prvi superračunalnik velja CDC6600, ki je bil najhitrejši računalnik med leti 1964-1969. Slika: Jitze Couperus.

Začnimo v prazgodovini, ko se je naš največji inštitut imenoval še Nuklearni institut Jožef Stefan (IJS) in so bili najboljši računalniki manj zmogljivi od današnjih ur in telefonov. Prvi računalnik, ki si je zaslužil oznako superračunalnik, je bil CDC 6600, ki ga je leta 1964 izdelal Control Data Corporation po idejni zasnovi očeta superračunalništva, Seymourja Craya. Prvega je, kot se za superračunalnike spodobi, kupil CERN. CDC 6600, ki je bil tolikšen kot štiri omare, je zmogel tri megaflopse (milijoni operacij s plavajočo vejico na sekundo). To je približno desettisočkrat manj kot novi iPhone.

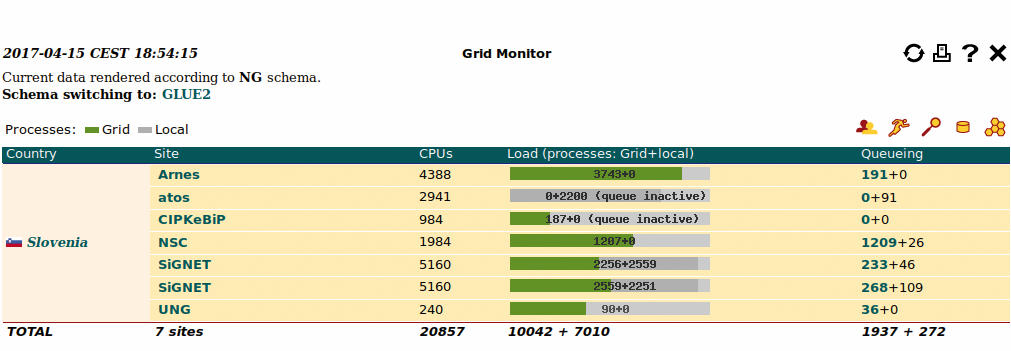

Poglavitna prednost grida SLING je enoten dostop, saj uporabnika ne zanimajo tehnične podrobnosti gruč.

Sledil je štirikrat hitrejši CDC 7600 leta 1969, desetkrat hitrejši CDC 8600 pa se zaradi tehničnih in finančnih težav ni nikoli »zgodil«. Naslednja družina CDD Cyber se v ameriških silosih medcelinskih raket uporablja še danes. Pa ni edini tak primer – Intelovi čipi i860 iz leta 1989, ki jih poznamo zaradi Intelovega superračunalnika Paragon, še vedno poganjajo lovce F-22 Raptor. Naslednji mejnik je bil Cray-1 istoimenskega podjetja, ki so ga leta 1976 namestili v Los Alamosu. Imenuje se po istem Seymourju Crayu, ki je leta 1972 zapustil CDC in ustanovil novo podjetje. Cray-1 je bil 64-bitni sistem, ki je zmogel 160 megaflopsov, tehtal je 5,5 ton in porabil 115 kW električne energije. Mejnik je tudi ASCI Red iz leta 1997, ki je bil prvi superračunalnik z zmogljivostjo več kot 1 teraflop, in to iz procesorjev Pentium Pro.

Kako pomemben je FLOPS

Primerjava zmogljivosti superračunalnikov je nehvaležno opravilo, ker so zgrajeni na zelo različnih arhitekturah in za reševanje različnih problemov. Neko merilo kljub temu želimo, zato tudi malo iz lenobe in prikladnosti uporabljamo vzporedno inačico testa LINPACK, ki se imenuje HPLinpack. Knjižnico LINPACK je Jack Dongarra razvil v 70. letih za izvajanje linearne algebre na računalnikih. Vzporedna različica tega testa (benchmark) se je do danes obdržala kot osnovno merilo za razvrščanje superračunalnikov, ki ga uporablja tudi najbolj znana lestvica Top 500.

Že kmalu po predstavitvi HPLinpacka so številni strokovnjaki izrazili kritike nad testom, ki da se uporablja predvsem zaradi enostavne rabe na različno velikih sistemih (scalability) in rezultata v obliki ene same primerljive številke. Očitajo mu, da je rezultat slabo koreliran z dejansko učinkovitostjo pri reševanju realnih problemov, kar je do neke mere problem vseh sintetičnih testov.

Zaradi tega superračunalnika IBM Blue Waters, ki ga upravlja ameriški Nacionalni center za uporabo superračunalništva (NCSA), sploh ni na lestvici. NCSA se je odločil, da ne bo sodeloval na lestvici, ker po njihovem mnenju rezultat v HPLinpacku ne pove nič o zmožnosti sistema, da rešuje realne probleme.

Joshua Mora iz AMD je že pred petimi leti pokazal, kako je mogoče »goljufati«. Vzel je AMDjev procesor Opteron 6275 in mu namenoma pohabil enoto za računanje s plavajočo vejico, da je delovala štirikrat počasneje. LINPACK je pokazal, da je tak procesor štirikrat počasnejši, pri reševanju realnih problemov pa je bil zgolj okrog osem odstotkov počasnejši.

Posebni mojstri te obrti so v formuli 1. Moštva si tam izdatno pomagajo z računalniškim modeliranjem CFD (computational fluid dynamics), a imajo v pravilih zapisano, koliko procesorskega časa lahko izrabijo. Točne številke so odvisne od nekaterih drugih testiranj, a na splošno velja, da se s standardnim testom preveri zmogljivost (v teraflopih) superračunalnika, ki ga ima moštvo na razpolago, potem pa se izračuna, koliko ur ga lahko uporabljajo. Ni težko uganiti, kaj se je zgodilo. Podjetja razvijajo posebej pohabljene superračunalnike, ki so na standardnem testu, recimo, 25 odstotkov počasnejši, pri modeliranju CFD pa zgolj pet odstotkov. In tako lahko moštva iz njih iztisnejo največ.

Pri nas je IJS kupil prvi računalnik ZUSE Z 23 leta 1962, deset let pozneje pa že slavni CDC Cyber 72. Vmes so prvi računalniki dobili na Fakulteti za matematiko in fiziko, leta 1974 pa na Kemijskem inštitutu, PDP 8. V 80. letih je Univerza v Ljubljani dobila DEC 10 in DEC 20, mariborska pa VAX 8800. Prvi superračunalnik v Sloveniji pa se je imenoval CONVEX C220 in so ga dobili na IJS leta 1989.

Možnosti

Čeprav na lestvici Top 500 ni nobenega slovenskega predstavnika, imamo v Sloveniji kar nekaj superračunalniških zmogljivosti. Žal so precej razdrobljene, zato je težko sestaviti izčrpen seznam. Kot povsod po svetu tudi pri nas podjetja, ki se ne ukvarjajo primarno z računalništvom, temveč računsko moč uporabljajo kot podporni sistem za oblikovanje svojih izdelkov, nerada razkrivajo svoje zmogljivosti.

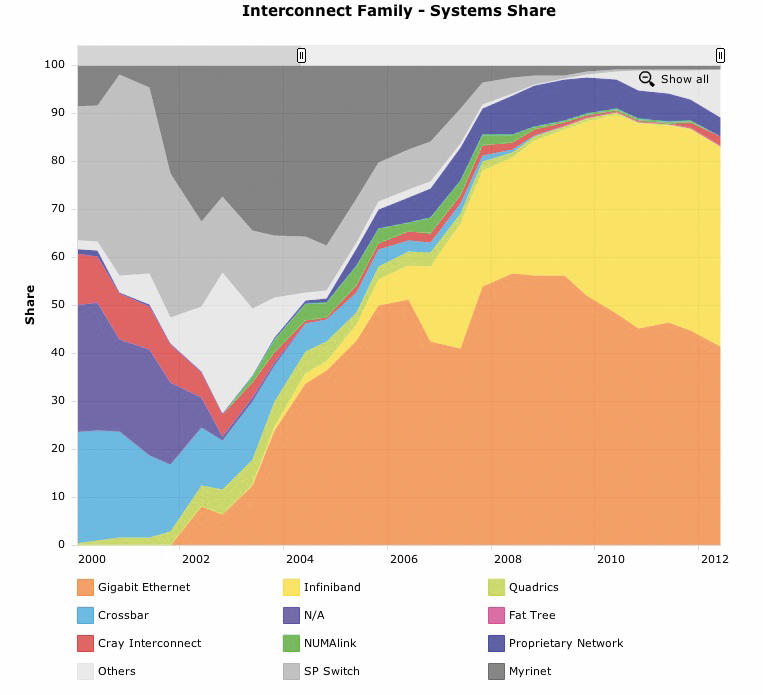

Danes je na voljo več načinov, kako priti do superračunalniških zmogljivosti. Najenostavnejša in najbolj priljubljena je postavitev gruče iz običajnih strežnikov, kar je zaradi nizke cene in zavidljivih zmogljivosti dandanes zelo pogosto. Tak sistem ni drag in je široko združljiv (zaradi arhitekture x86), saj na njem teče neka distribucija Linuxa. V tipični gruči je nekaj tisoč jeder, vozlišča pa so povezana s hitrimi povezavami Infiniband.

Pogosto naletimo na termin Beowulf, ki sta ga leta 1994 postavila Thomas Sterling in Donald Becker v NASI. Z njim označujemo superračunalnik, ki ga sestavljajo medsebojno povezani računalniki za pisarniško rabo. Na njih teče neka distribucija Linuxa s knjižicami za vzporedno računanje, komunikacija pa je navadno prek etherneta. To ni nič slabšalnega – danes so številni superračunalniki omare čisto običajnih strežnikov, po možnosti povezanih prek Infinibanda.

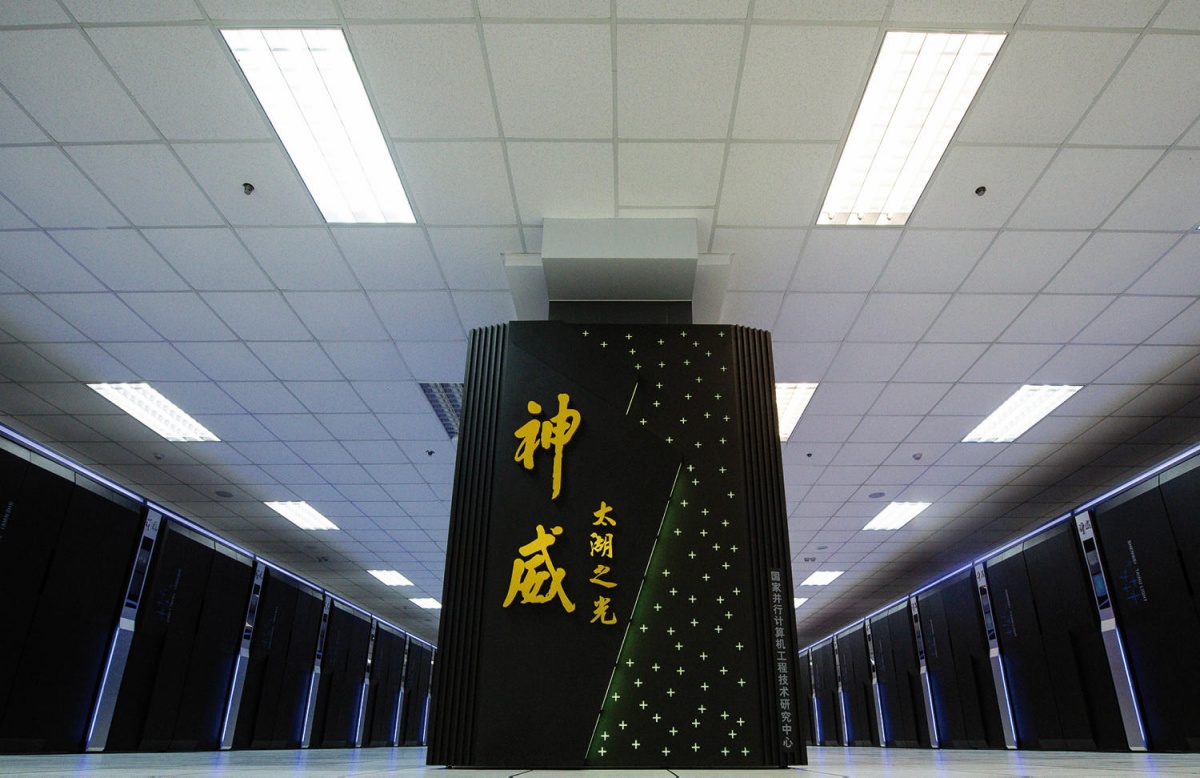

Najzmogljivejši superračunalnik na svetu je kitajski TaihuLight, ki z 10 milijoni jeder zmore 93 gigaflops ob porabi 15 MW električne energije. Slika: Top500.org

Namenski superračunalniki, kot so na lestvici Top 500, so dražji in zmogljivejši, zato si jih privoščijo le najbogatejši. Za namenske aplikacije je takšna rešitev učinkovitejša, a dražja. Ne smemo pozabiti niti na možnost oblačnega računalništva, ki je dandanes zelo uporabno. Številna podjetja (Amazon, Google, Microsoft) ponujajo najem svojih računskih ciklov, kar je pogosto najcenejša rešitev, ker se nam ni treba ukvarjati s postavljanjem in vzdrževanjem superračunalnika.

Zadnja možnost je gruča gruč ali, s tujko, grid. Po različnih institucijah in državah imamo razpršenih zelo veliko računskih zmogljivosti (glej slovenske v nadaljevanju), za katere je škoda, če imajo neizkoriščene cikle. Hkrati z velikim hadronskim trkalnikom v CERNu in kasneje še drugimi so vzniknili projekti, ki ustvarijo toliko podatkov, da jih nobena gruča ne more obdelati. Grid je povezava dislociranih gruč, do katerih dostopamo prek enotnega vmesnika.

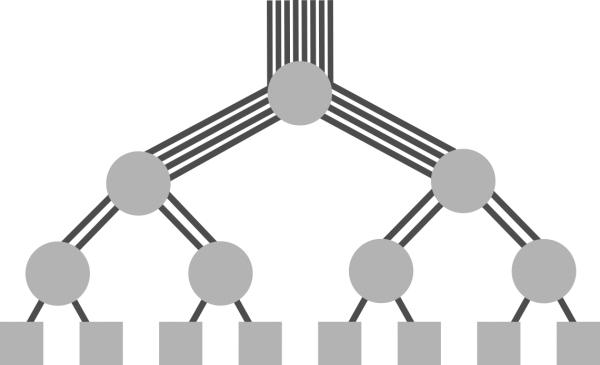

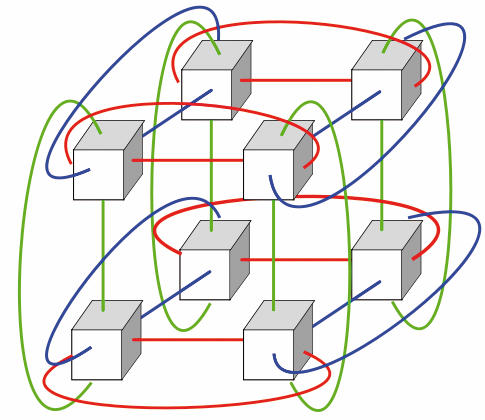

Najpogostejši topologiji povezav vozlišč z Infinibandom se imenujeta fat tree in 3D torus.>

SLING

V Sloveniji smo hitro stopili v korak z modernimi smernicami in dobili Slovensko iniciativo za nacionalni grid ali, krajše, SLING, ki sta jo ustanovila ARNES in IJS. IJS že od leta 2004 sodeluje pri razvoju programske opreme za uporabo grida. Od leta 2009 SLING vodi ARNES, ki Slovenijo tudi zastopa v mednarodnih organizacijah in v SLING prispeva svojo gručo. V Evropi namreč od leta 2010 deluje Evropska iniciativa za grid (EGI), katere del je tudi SLING. IJS je v ustanovitev SLINGa prispeval znanje, ARNES pa infrastrukturo in podporo.

Zasedenost kapacitet v SLING-u lahko spremljamo na sling.si/gridmonitor/loadmon.php.

Pred EGI so bili le manjši projekti, na primer DataGrid, EGEE I, EGEE II in EGEE III (Enabling Grids for E-sciencE), nemški Unicore ali skandinavski NorduGird. Uspešnost teh projektov je pokazala na potrebo po vseevropskem gridu in rojen je bil EGI, v katerem sodelujejo nacionalne iniciative za grid in ki zagotavlja stalne računske zmogljivosti raziskovalnim institucijam in mednarodnim projektom (npr. ATLAS v CERN-u). SLING in EGI imata za razliko od projektov trajno financiranje.

Koliko podatkov proizvede CERN

Projekti v okviru velikega hadronskega trkalnika (LHC) v CERN-u so najbolj znan primer generiranja velikanskih količin podatkov, ki jih je treba shraniti in obdelati. En sam detektor lahko proizvede 1 PB podatkov na sekundo, to pa je preveč. Ker je večina dogodkov nepomembnih, se podatki o njih zavržejo. Shranijo se le najzanimivejši, ki jih je po prehodu več filtrov še vedno okrog 1 GB vsako sekundo. Vsako leto samo LHC pridela okrog 30 PB podatkov. Za shranjevanje in obdelavo tako velike količine podatkov so edina možnost gridi (in to ne le EGI).

V SLINGu s svojimi zmogljivostmi (bodisi računskimi bodisi drugačnimi) sodelujejo Arctur, ARNES, ARSO, Comtrade, FIŠ, IJS, Univerza v Novi Gorici in Xenya, tako da je trenutno na voljo več kot 20.000 jeder. Zmogljivosti v SLINGu lahko brezplačno uporablja vsak raziskovalec v slovenskem prostoru, ki pri SiGNETu pridobi digitalno potrdilo. S tem potrdilom se prijavi v sistem, odloži svoje račune in po izračunu prekopira podatke. SLING se uporablja tako za čisto krajevne projekte kakor za sodelovanje v velikih konzorcijih, kot je kolaboracija ATLAS v CERNu.

Poglavitna prednost je enoten dostop do virov, tako da uporabnika ne zanimajo tehnične podrobnosti gruč, ki so priključene v SLING. Vmesna programska oprema poskrbi, da razlike niso pomembne. Glede na nalogo, ki jo uporabnik predloži v grid, samodejno izbere najprimernejšo gručo in spremlja dogajanje. Vsaka gruča je dostopna tako lokalno (recimo gruče na IJS za potrebe zaposlenih na institutu) kakor tudi prek grida, kjer se delijo neizkoriščene zmogljivosti.

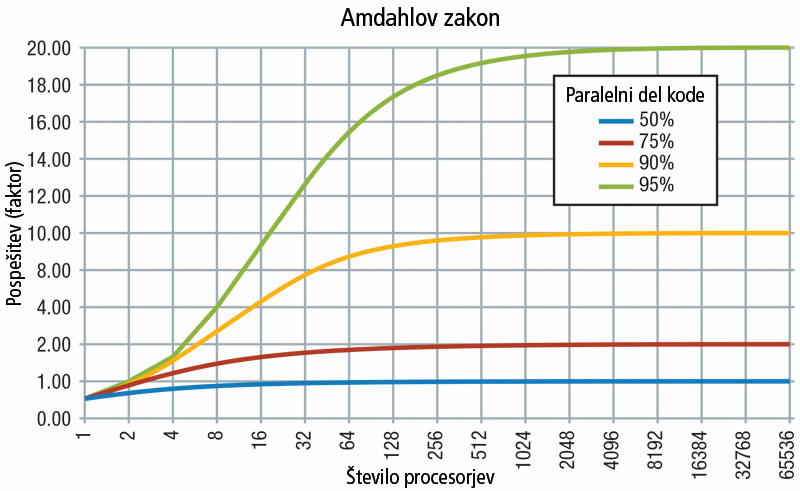

Amdahlov zakon: pospešitev programa pri izvajanju na več jedrih je odvisna od deleža kode oziroma problema, ki je paralelizabilen.

Arhitektura: novosti in relikvije

Podati enoznačen opis, kako je zgrajen superračunalnik, je nemogoče, ker so si med seboj precej različni. Kljub temu za veliko večino danes velja, da jih sestavljajo vozlišča, ki so nekakšni samostojni računalniki. Krmili jih glavno vozlišče (master node), kamor se uporabniki prijavijo in pošljejo svoje naloge. To potem razdeli naloge med računska vozlišča (compute node) oziroma delavce (working node). Ti so navadno enaki.

Kako superračunalniki rešujejo svet

Verjetno si marsikdo težko predstavlja, kaj so ti računsko zahtevni problemi, ki jih rešujemo s superračunalniki. Z razvojem jih je čedalje več, med najznačilnejše pa sodijo:

• Vremenske napovedi

• Iskanje zdravil

• Opis kompleksnih skupin atomov in molekul

• Obdelava velikih količin podatkov (zemljevidi, jezikoslovje)

• Fizika osnovnih delcev

Ta zasnova velja že trideset let in nič ne kaže, da bi se v prihodnosti spremenila. Podobno ostaja enak način dela. Na superračunalnikih teče neka distribucija Linuxa, v katero se oddaljeno prijavimo (ssh) v ukazni vrstici. Potem naložimo datoteke s potrebnimi vhodnimi podatki, poženemo naloge oziroma posle in počakamo na konec, ko z gruče snamemo datoteke z rezultati. V znanosti je še vedno kup kode, tako komercialne kot lastne, napisane v fortranu in nekaj v Cju. Moderni jeziki (npr. X10 ali Chapel), ki so tudi primernejši za paralelizacijo, se le počasi uveljavljajo. Pri razvoju procesorjev smo trčili ob omejitve fizike, zato se povečuje le še število jeder. Dandanes dobivajo vozlišča tudi zmogljive grafične kartice s stotinami grafičnih procesorjev, ki so zelo primitivni, a za določene naloge zelo primerni, ker jih je veliko.

Pomemben vidik superračunalnika je diskovno polje. To je navadno poseben strežnik NFS (network file system), ki vsebuje veliko diskov v neki sestavi RAID. Pri tako velikem številu diskov je treba resno računati z verjetnostjo, da kateri odpove, a to ne sme vplivati na delovanje gruče. Pri tem pogosto pozabljamo, da so enaki diski sicer dobrodošli s stališča sestave in delovanja sistema, a prinašajo tveganja. Verjetnost, da posamezen disk odpove, tedaj ni več neodvisna, temveč je verjetneje, da jih bo odpovedalo več hkrati, kakor če bi bili diski različni. To se dogaja – gruča na enem izmed ljubljanskih inštitutov je lani decembra izgubila tri diske. Ker sta bila redundantna le dva diska, je bilo reševanje podatkov zahtevno, saj je bilo treba diske odpeljati k strokovnjakom za obnovo podatke, da so vsaj z enega rešili podatke in obnovili celotno polje. Podatki v NFS so vidni vsem vozliščem, zato tega diskovnega polja za izračune ni primerno uporabljati. Vsako vozišče ima tudi svoj disk in če lahko neki posel teče le na enem vozlišču, je bistveno bolje uporabljati ta disk, da ne obremenjujemo omrežja.

Če pa potrebujemo sodelovanje več vozlišč, trčimo ob problem povezljivosti. Povezava z ethernetom je topološko enostavna, a počasna. Poleg nizke hitrosti komunikacije ethernet zelo obremenjuje procesor, ima visoke latence in prinaša veliko nepotrebne navlake v komunikaciji (overhead). Zato se danes uporablja InfiniBand, kjer pa stanje ni tako enostavno. Poleg različnih inačic samega standarda je cela znanost o topologiji povezav, med katerimi sta najbolj priljubljeni 3D torus in fat tree.

Slovenske gruče in superračunalniki

Kot smo videli, so nekatere slovenske gruče povezane v nacionalni grid SLING, druge akademski uporabniki izkoriščajo le za lastne raziskave, tretje imajo posebne namene (npr. ARNESova gruča in DRO), četrte pa imajo podjetja in njihovega obstoja ne obešajo na veliki zvon. V nadaljevanju so predstavljene najpomembnejše gruče v Sloveniji in še nekaj manjših. Nedvomno je še kakšna manjša, ki smo jo izpustili, a na seznamu ni pomembnejših vrzeli.

ARNES. ARNESova gruča ima danes več kot 4400 jeder in opravlja funkcijo nacionalne testne gruče. Za razliko od drugih gruč, ki imajo bolj ali manj določen namen rabe, lahko ARNESovo gručo uporabljajo vsi člani SLINGa. Čeprav je namenjena zlasti preizkušanju uporabe tehnologij za grid, pa to ni njena edina raba.

Arctur. Novogoriško podjetje Arctur je eden izmed pionirjev slovenskega superračunalništva. Leta 2010 so postavili superračunalnik Arctur-1, ki ga je sestavljalo 84 vozlišč BM iDataPlex dx360 M3, vsako s po dvema šestjedrnima procesorjem Intel Xeon X5650 s frekvenco 2,66 GHz, vse povezano z Infinibandom QDR. Skupno je imel 1008 jeder in 2,66 TB pomnilnika, kar so na oko ocenili na 10 teraflopov.

Slovenski superračunalnik Arctur-2. Slika: Arctur.si.

Danes večino dela opravijo na novem sistemu Arctur-2, ki je stal približno 4,3 milijona evrov. Arctur-2 sestavlja 1008 jeder v procesorjih Intel Xeon E5 v4 ter 224 jeder v sistemu SMP (simetrično multiprocesiranje), poleg tega pa ima še številne grafične procesorje in 1,5 PB diskovnega polja.

Arctur poganja komercialni superračunalnik, ki je namenjen strankam. Te lahko dobijo dostop SSH za poganjanje programov ali pa celovitejšo storitev, odvisno od potreb in znanja. Trenutno zmogljivost uporabljajo večinoma znanstvene ustanove, med katerimi so tako domače (npr. Nacionalni inštitut za biologijo) kakor tudi tuje (tržaški Mednarodni center za teoretično fiziko – ICTP). Domača industrija se še sramežljivo spogleduje s superračunalništvom (recimo Seaway, Pipistrel, Cimos), precej pa imajo naročil tujih podjetij.

Institut Jožef Stefan. Na našem največjem raziskovalnem inštitutu je precej raziskovalnih skupin, ki potrebujejo veliko računske moči, iz zgodovinskih razlogov pa imajo več gruč. Za celotni IJS skrbi gruča NSC, ki je tudi del SLINGa. To gručo sestavlja 1984 jeder, 16 kartic Nvidia Tesla K40 in 9216 GB pomnilnika, vse skupaj povezano z Infinibandom.

Odsek za reaktorsko tehniko (R4) ima še tri starejše gruče, in sicer Mangrt (iz leta 2007), Krn (2010 z nadgradnjo 2012) in Razor (2014 z nadgradnjo 2015). Najstarejši, Mangrt, ima 52 jeder v obliki procesorjev Intel Xeon 5160 s 3,0 GHz in 104 GB pomnilnika. Krn ima 50 vozlišč s po dvema procesorjema Intel Xeon E5-2670, 5650, 5670 ali X5675, skupno 600 jeder. Povezana so z Infinibandom QDR in imajo skupno 2040 GB pomnilnika in 17 TB veliko diskovno polje. Nekatera vozlišča imajo še grafične procesorje, in sicer Quadro FX 3800, Quadro 6000 in Tesla M2075. Najnovejši, Razor, pa ima 1096 jeder, ki jih zagotavljajo procesorji Intel Xeon E5-2680 v2 (2,8 GHz) in E5-2697 v2 (2,7 GHz) in v3 (2,6 GHz).

Superračunalnik v velikem hadronskem trkalniku. Večino podatkov obdelajo v največjem gridu na svetu WLCG (Worldwide LHC Computing Grid), ki ga sestavljajo evropski grid EGI, ameriški Open Science Grid in številni regionalni in nacionalni gridi.

Svojo gručo ima tudi Odsek za eksperimentalno fiziko osnovnih delcev (F9), ki sodeluje tudi pri velikih projektih, kot so ATLAS, DELPHI in HERA-B v CERNu ali Belle v japonski Tsukubi. F9 ima gručo SiGNET s 5160 jedri, ki je del SLINGa. Odsek za teoretično fiziko (F1) ima gručo s skoraj 3000 jedri, CIPKeBiP (Center odličnosti za integrirane pristope v kemiji in biologiji proteinov), katerega soustanovitelj je IJS in deluje v njegovih prostorih, pa še 984 jeder.

ARSO. Značilna raba, pri kateri potrebujemo veliko računske moči, je napovedovanje vremena. Zato ni presenetljivo, da Agencija Republike Slovenije za okolje (ARSO) že od leta 1993 širi svoje računske zmogljivosti. Začelo se je z delovno postajo HP 720, kjer pa vremenskih simulacij še ni bilo mogoče poganjati, je pa v njej gostoval spletni strežnik tedanjega Hidrometeorološkega zavoda. Leta 1995 so z Digital Alpha 5/333, ki je imel procesor s taktom 333 MHz, 256 MB pomnilnika in 120 GB diskovnega prostora, začeli poganjati prve vremenske simulacije. Leta 1998 so postavili gručo Alibaba, ki jo je sestavljalo 20 delovnih postaj Alpha 21164sx s 533 MHz procesorji, povezanih prek etherneta. To je bila prva gruča na svetu, ki je meteorološki model ALADIN poganjala na Linuxu. Sledila je še gruča Tuba leta 2002 in superračunalnik SGI-ICE 8200, ki so ga postavili leta 2007 in je imel že povezavo z Infinibandom.

Zadnjo večjo posodobitev je ARSO dobil leta 2013, ko so postavili superračunalnik SGI ICE-X z zmogljivostjo 22 TFLOPS. Tega sestavlja 62 vozlišč s po dvema procesorjema Intel Xeon E5-2670 z 2,60 GHz, ki imajo po osem jeder in 2 GB pomnilnika na jedro. Vozlišča so povezana z Infinibandom FDR (56 Gb/s), skupno pa je na voljo 120 TB diskovnega prostora in 1 PB na tračni knjižnici. Tak sistem, ki ga poganja SUSE Linux Enterprise Server 12, porabi okrog 20 kW električne energije in stane 650.000 evrov, pojasnjuje Jure Jerman z ARSO. V pripravi je nadgradnja sistema, ki bo prinesla 12 novih vozlišč, s čimer se bo zmogljivost povečala na 28 teraflopov.

Na SGI ICE-X poganjajo vrsto modelov, med katerimi je javnosti najbolj znan model za napovedovanje vremena ALADIN, sicer pa imajo še CAMX (kemija sestave ozračja), POM in WAM (dinamika in valovanje morja), Krokus (snežna odeja), INCA (nowcasting – napovedovanje trenutnih razmer) in različne prilagoditve klimatskih scenarijev na regionalno merilo. ALADIN ima trenutno horizontalno ločljivost 4,4 km, po nadgradnji pa bo 2,2 km. Trenutno ga sestavlja okrog tri milijone vrstic (dobrih 200 MB) kode, ki je večidel napisana v fortranu, malo pa tudi v C++.

ARSO svoj SGI ICE-X uporablja interno, starejši SGI-ICE 8200 pa bodo vključili v SLING, kjer bo brezplačno na voljo za razvoj in testiranje vzporedne programske kode.

Najpomembnejša načina povezav znotraj gruče sta gigabitni ethernet in Infiniband. Slika: Gigaom.com

Kemijski inštitut. Svoj superračunalnik ima tudi ljubljanski Kemijski inštitut. Z njim izvajajo kemijske simulacije na različnih stopnjah – od presejalnih testov (screening) prek molekulske dinamike do kvantnomehanskih simulacij. V resnici sta gruči dve, in sicer starejša VRANA in novejši HPC.

VRANA deluje v okviru Odseka za molekularno modeliranje (D17) in je najstarejša gruča na Kemijskem inštitutu, ki pa se sproti nadgrajuje. Trenutno ima na razpolago skoraj tri tisoč jeder iz različnih inačic Intelovih Xeonov in nekaj AMDjevih Opteronov 6128.

HPC, ki je namenjen vsem uporabnikom na inštitutu, pa sestavlja 1824 jeder, 3,6 TB pomnilnika in 182 TB diskovnega polja. Gre za 16 vozlišč s po dvema 20-jedrnima Intel Xeon E5-2260v3 z 2,6 GHz in 32 GB pomnilnika, 20 vozlišč s po dvema 16-jedrnima Intel Xeon E5-2660 z 2,2 GHz in 64 GB pomnilnika, 6 vozlišč s po dvema 16-jedrnima AMD Opteron 6128 z 2,0 GHz in 16 GB pomnilnika, 17 vozlišč s po štirimi 32-jedrnimi AMD Opteron 6128 z 2,0 GHz. Nekateri so med seboj povezani z Infinibandom, starejši pa ne.

Kemijski inštitut ni član SLINGa, računske zmogljivosti pa so namenjene raziskovalcem inštituta.

Za največje projekte niti najbogatejše države nimajo dovolj velikih gruč, zato je uporaba grida nujna.

Fakulteta za informacijske študije. Na novomeški FIŠ so leta 2014 postavili superračunalnik Rudolf, ki sicer fizično gostuje v ARNESovem podatkovnem centru, da je bolje povezan z drugimi gručami v slovenskem gridu SLING. Sestavlja ga 44 vozlišč s po dvema procesorjema Intel Xeon E5-2650 v2 z 2,6 GHz in 64 GB pomnilnika ali 128 GB (takih je osem) pomnilnika, povezanih prek Infinibanda FDR. Za pedagoške potrebe imajo na voljo še eno grafično kartico Tesla K20 in eno kartico Intel Xeon Phi 7120. Skupno zmore gruča okrog 15 teraflopov in ima 72 TB veliko diskovno polje. Poganja ga CentOS Linux. Tak sistem je stal 416.000 evrov, uporablja pa se pri raziskovalnih projektih, ki tečejo na FIŠ. Kot članica SLINGa FIŠ neizkoriščene zmogljivosti ponuja drugim članom in nasprotno, je pojasnila Ana Čefarin s FIŠ.

Fakulteta za strojništvo. Solidno gručo po imenu HPCFS-U ima tudi ljubljanska FS. Prvotni superračunalnik HPCFS ima 768 jeder, 3 TB pomnilnika in 20 TB diskovnega polja. Gre za 64 vozlišč, ki vsebujejo po dva šestjedrna procesorja Intel Xeon X5670 s frekvenco 2,93 GHz in 48 GB pomnilnika. Povezana sta z Infinibandom QDR. Dodatni superračunalnik HPCFS-U ima še 528 jeder, od tega 20 vozlišč s po dvema dvanajstjedrnima Intel Xeon E5-2680V3 (2,5 GHz) in 64 GB pomnilnika, ter še dve enaki vozlišči – eno virtualizacijsko in eno s pospeševalniki. Slednje ima tri grafične kartice Tesla K80. Tudi ta vozlišča so povezana z Infinibandom.

Fakulteta za kemijo in kemijsko tehnologijo. Manjšo gručo ima tudi ljubljanska FKKT. Sestavlja jo 20 vozlišč s štirijedrnimi procesorji Intel Core i5-2500 s 3,3 GHz, 16 vozlišč s štirijedrnimi procesorji Intel Core i7 4790K s frekvenco 4,2 GHz in 6 vozlišč z i7 6700K s 4,0 GHz. Ob tem imajo na razpolago še eno grafično kartico Tesla C2075, en strežnik z dvema Xeonoma E5-2630 (2,4 GHz) in štirimi Xeon Phi 31S1P. Skupno gre za 190 procesorskih jeder in 228 grafičnih jeder. Postaje so med seboj povezane z ethernetom. Ker ne gre za pravi superračunalnik, temveč zgolj za v gručo povezane nekoliko boljše delovne postaje, ki se uporabljajo za interne raziskovalne namene, tudi ni del SLINGa.

Turboinštitut. Enega izmed prvih superračunalnikov v Sloveniji je leta 2008 dobil Turboinštitut. Gruča 2048 jeder iz strežnikov IBM BladeCenter, ki so imeli vsak po dva štirijedrna procesorja, je imela 4,1 TB pomnilnika in se je ob postavitvi s 36 gigaflops uvrščala med 250 najhitrejših superračunalnikov na svetu.

Univerza v Novi Gorici. Na UNG imajo manjšo gručo, ki ima v SLING povezanih 240 jeder.

Državni računalniški oblak. Konec leta 2015 je Ministrstvo za javno upravo postavilo DRO, ki naj bi omogočil centralizacijo informatike v državni upravi, ki je bila dotlej razpršena po 120 lokacijah. Šlo je za 14 milijonov evrov težak projekt, ki je prinesel tri enakovredne infrastrukture in skupno 1600 jeder in 1700 TB veliko diskovno polje. Sem seveda ni zajeta le strojna oprema, saj je polovica denarja šla za varnost, programsko opremo, storitve in promocijo. DRO je v 85 odstotkih financirala EU.

Ne gre za superračunalnik v klasičnem pomenu besede, saj se na njem ne rešujejo zapleteni računski problemi, temveč gre za podporno storitev za državno upravo. Tako ni povezav v internet ali zunanje oblačne infrastrukture in nima prosto dostopnih storitev ali nepooblaščenih uporabnikov. Namenjen je predvsem lažjemu izvajanju nalog državne uprave, obljublja pa prihranke zaradi centralizacije in zato cenejšega vzdrževanja in nadgrajevanja.

Trenutno ga sestavlja 24 strežnikov Lenovo Think Server TS RD 550, 96 rezin Dell M630 (skupno 1228 jeder) in Dellova diskovna polja VNX 5800, ISILON, EMC XIO in EMC Data Domain.

Zakaj posebej?

Na področju superračunalništva bi Sloveniji lahko marsikdo očital, da vlada izrazito vrtičkarstvo. Vsaka raziskovalna inštitucija ima svojo gručo, v večjih pa imajo poleg skupne na nekaterih odsekih tudi lastne. To pomeni, da posamezne gruče ne presegajo nekaj tisoč jeder ali nekaj deset teraflopov. Koliko zmogljivosti je v zasebnih podjetjih, javno ni znano. Če bi namesto tega zgradili en superračunalnik, bi dosegli nekaj sto teraflopov. Zakaj ga torej ne?

Razlogov je več in večina nima nič opraviti z nečimrnostjo, temveč gre za objektivne omejitve. Najprej povejmo, da veliko tehnoloških problemov strašne paralelizacije ne potrebuje. Redki so primeri, ko je treba pognati eno veliko in dolgo simulacijo. Navadno je treba pognati na desetine ali stotine simulacij, ki med seboj ne komunicirajo, zato je čisto vseeno, kje in kako jih poganjamo. Naslednja stvar so različne varnostne politike, kar je problem zlasti za komercialno rabo, kjer podatki fizično ne smejo iz podjetja.

Na koncu pridemo do financiranja. Današnje oblačne rešitve, kot je, denimo, AWS iz Amazona, Google Cloud Platform ali Microsoft Azure, so že zelo poceni in v številnih primerih bi jih bilo ceneje najemati kakor postavljati in vzdrževati lastno infrastrukturo. Seveda ne moremo in smemo odprodati vse infrastrukture, saj je temeljni cilj raziskovalno-izobraževalnih inštitucij tudi šolanje domačega kadra. Potrebujemo ljudi, ki znajo postaviti svojo gručo, in take, ki znajo uporabljati grid in oblačne storitve.

Denar, ki se deli na trenutnih razpisih, je strogo namenski. Če se v projekt napiše, da bomo potrebovali veliko računske moči in zato toliko in toliko tisoč jeder, je treba ta denar tudi porabiti za nakup take infrastrukture. Precej teže pa je pridobiti projekt, kjer je zapisano, da bo toliko in toliko denarja šlo za plačilo računalniških storitev v oblaku – ker to ni več raziskovalna infrastruktura. A to je že druga, politična zgodba na ravni EU in Slovenije.

Zato je treba pozdraviti pobudo SLING za slovenski grid. V njem imamo zbranih več kot polovico vseh koncentriranih računskih zmogljivosti v Sloveniji, ki jih lahko brezplačno izkoriščajo vsi raziskovalci in drugi člani. Ker se SLING povezuje tudi v evropski EGI (Evropska iniciativa za grid), to zaenkrat povsem zadostuje. Za velikanske projekte, kot sta ATLAS ali CMS v CERNu, pa niti najbogatejše države nimajo dovolj opreme, zato je tam uporaba grida nujna.