Šestega maja 2010 je ob 14. uri in 32 minut po vzhodnem standardnem času z ameriške borze v 20 minutah izpuhtel skoraj bilijon dolarjev. To je bil takrat največji upad vrednosti v zgodovini. Nato si je trg skoraj enako hitro vnovič opomogel…

Grace Huckins, MIT Technology Review

Po nekajmesečni preiskavi so pristojni večino odgovornosti za bliskoviti zlom pripisali trgovalnim algoritmom, ki s svojo bliskovito hitrostjo izkoriščajo vse priložnosti za zaslužek. Ti sistemi resda niso povzročili požara, vendar so delovali kot pospeševalci gorenja: ko so se cene začele zniževati, so hitro začeli prodajati in cene so upadale še hitreje, avtomatizirani borzni posredniki so prodali še več in sprožil se je plaz.

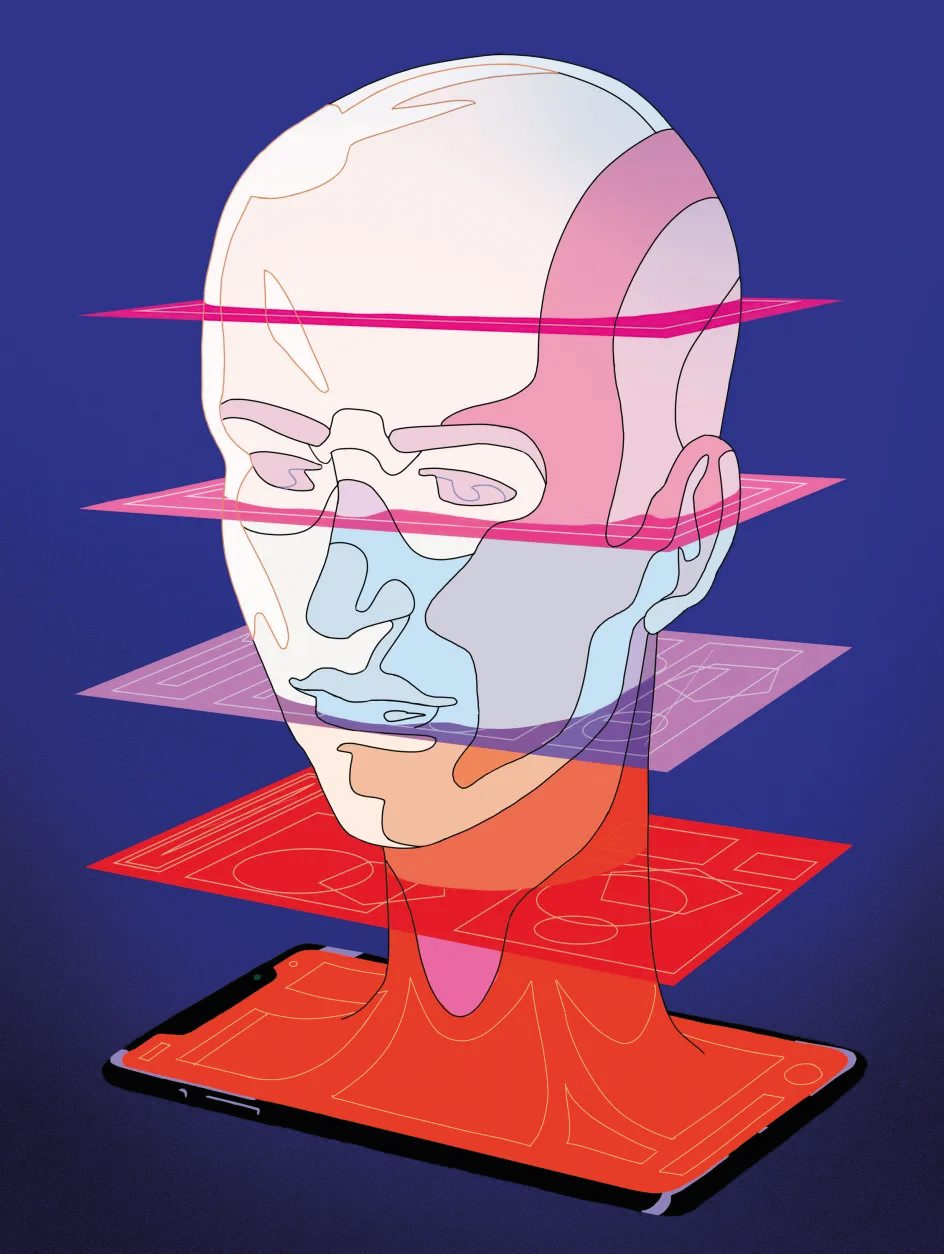

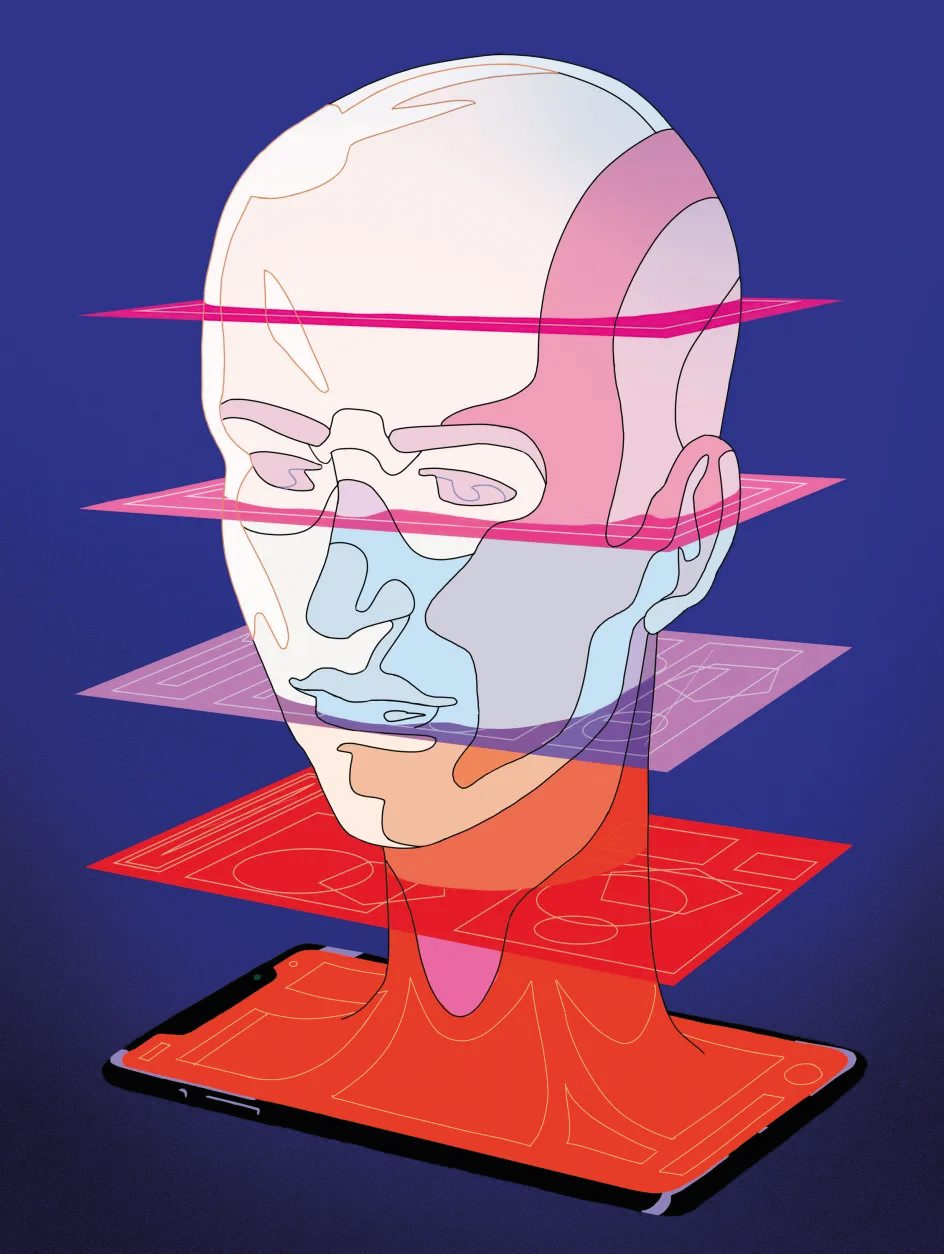

Hitri upad je najbrž najbolj znani primer nevarnosti, ki jo lahko povzročijo agenti – avtomatizirani sistemi, ki delujejo v resničnem svetu brez človekovega nadzora. Ta moč je vir njihove vrednosti: agenti, ki so zagnali upad, posle sklepajo veliko hitreje od vseh ljudi. A to je hkrati tudi razlog, da lahko povzročijo takšno zmedo. »Veliko protislovje agentov tiči v tem, da se je za njihovo uporabnost – zmožnost opravljati vrsto nalog – treba odpovedati nadzoru nad njimi,« je pojasnil Iason Gabriel, starejši raziskovalec v laboratoriju Google DeepMind, ki se posveča etiki umetne inteligence.

Agenti so že desetletja vsepovsod. Hišni termostat je agent – samodejno poveča ali zmanjša ogrevanje, da je v hiši stalna temperatura. Agenti so tudi protivirusni programi in robotski sesalniki. Tudi oni podobno kot visokofrekvenčni posredniki, ki so programirani za prodajo oziroma kupovanje glede na tržne razmere, opravljajo točno določene naloge po vnaprej znanih pravilih. Celo bolj zapleteni agenti, kot so Siri in samovozeči avtomobili, sledijo vnaprej pripravljenim pravilom.

Veliko protislovje agentov tiči v tem, da se je za njihovo uporabnost – zmožnost opravljati vrsto nalog – treba odpovedati nadzoru nad njimi.

Zadnje mesece pa na prizorišču izstopa nov razred agentov, ki temeljijo na velikih jezikovnih modelih. Operator, agent podjetja OpenAI, lahko samostojno upravlja brskalnik in naroči hrano ali rezervira mizo v restavraciji. Sistemi, kot sta Claude Code in Cursor's Chat, lahko z enim ukazom spremenijo programsko kodo. Manus, agent kitajskega zagonskega podjetja Butterfly Effect, postavlja in upravlja spletne strani skoraj brez človekovega vmešavanja. V njihovo domeno bi lahko sodila vsa dejanja, ki jih je mogoče opisati z besedami, od igranja videoiger do pisnih ukazov za upravljanje računa na družbenih omrežjih.

Agenti na temelju velikih jezikovnih modelov še nimajo dolge zgodovine, vendar so vodilni v panogi prepričani, da bodo že kmalu preobrazili gospodarstvo. Direktor OpenAI Sam Altman pravi, da se bodo agenti kmalu pridružili delovni sili, direktor Salesforcea Marc Benioff pa energično oglašuje Agentforce, platformo, ki podjetjem omogoča prilagajanje agentov svojim potrebam. Ameriško obrambno ministrstvo je nedavno podpisalo pogodbo s Scale AI za zasnovo in testiranje agentov za vojaške namene.

Tudi drugi strokovnjaki agente jemljejo resno. »To je naslednji mejnik,« je prepričana Dawn Song, predavateljica na fakulteti za elektrotehniko in računalništvo pri kalifornijski univerzi v Berkeleyju. Hkrati dodaja: »Da bi nam umetna inteligenca (UI) dejansko koristila pri reševanju zapletenih nalog, moramo poskrbeti tudi za njeno varno in zanesljivo delovanje.«

To bo zahtevna naloga. Tako kot klepetalniki na temelju velikih jezikovnih modelov se tudi agenti lahko vedejo zmedeno in nepredvidljivo. V bližnji prihodnosti bi agent z dostopom do bančnega računa lahko pomagal pri načrtovanju proračuna in plačevanju obveznosti, vendar bi utegnil tudi zapraviti vse prihranke ali podatke posredovati hekerju. Agent, ki bi urejal profile na družbenih omrežjih, bi lahko prevzel nekaj bremena pri vzdrževanju prisotnosti in opaznosti na spletu, vendar bi lahko tudi širil neresnice in zlorabil druge uporabnike.

Yoshua Bengio, predavatelj računalništva na montrealski univerzi in eden tako imenovanih botrov UI, se pridružuje tistim, ki izražajo zaskrbljenost zaradi takšnih pasti. Najbolj pa ga skrbi možnost, da bi si veliki jezikovni modeli lahko postavili lastne prednostne naloge in se začeli posvečati lastnim nameram, nato pa bi na tej podlagi delovali – kolikor pač morejo – v resničnem svetu. Veliki jezikovni model v oknu za klepet brez človekove pomoči ne more prav veliko, močan agent UI pa bi se lahko podvojil, povozil varovalke ali onemogočil, da se ga ugasne. Na tej stopnji bi potem lahko počel, kar bi mu padlo na pamet.

Za zdaj ni popolnoma zanesljivega jamstva, da bodo agenti delovali, kot so si zamislili razvijalci, in da nepridipravom lahko preprečimo zlorabe. Čeprav si strokovnjaki na vso moč prizadevajo razviti nove varnostne mehanizme, jim morda ne bo uspelo dohajati hitrega nadgrajevanja agentov. »Če bomo nadaljevali na trenutni poti razvoja sistemov agentov, bomo pravzaprav igrali rusko ruleto s človeštvom,« opozarja Bengio.

Operator, agent podjetja OpenAI, lahko samostojno upravlja brskalnik in naroči hrano ali rezervira mizo v restavraciji.

Delovanje velikega jezikovnega modela je presenetljivo preprosto prenesti v resnični svet, le povezati ga je treba z orodjem, torej s sistemom, ki besedilo lahko prevede v dejanja, modelu pa dati navodila, kako uporabljati to orodje. Čeprav ni enotne definicije, kaj je veliki jezikovni model, ki ni agent, neizpodbitno velja, da je to vse redkejši pojav, saj najbolj priljubljeni modeli ChatGPT, Claude in Gemini lahko uporabljajo spletna iskalna orodja za sestavljanje odgovorov na vprašanja uporabnikov.

Slab veliki jezikovni model ne bi mogel postati učinkovit agent. Ta mora namreč razumeti abstraktne namene uporabnika, narediti načrt, kako doseči cilj, in nato uporabiti razpoložljiva orodja, da uresniči načrt. Razumni veliki jezikovni modeli, ki 'razmislijo' o svojem odgovoru v dodatnem besedilu, v katerem pravzaprav govorijo s samim seboj in se tako prebijejo skozi nalogo, pa so zelo dobro izhodišče za razvijanje agentov. Zelo pomembno je tudi, da modelu dodamo dolgoročni spomin, na primer dokument, v katerega shranjuje pomembne podatke ali beleži posamezne korake načrta, hkrati pa tudi povratne informacije o tem, kako dobro mu gre naloga od rok. Modelu bi lahko pokazali, kako je vplival na svojo okolico ali mu natančno opisali, ali je opravil nalogo oziroma ali mu je spodletelo.

Takšni sistemi so že pokazali nekaj skromnih uspehov pri zbiranju denarja v dobrodelne namene in igranju videoiger, in to brez izrecnih navodil. Če imajo zagovorniki agentov prav, je veliko možnosti, da bomo uporabnim sistemom UI z dostopom do našega poštnega predala in koledarja kmalu lahko predali najrazličnejše naloge, od odgovarjanja na elektronska sporočila in dogovarjanja za sestanke do pošiljanja računov, za kar ne bodo potrebovali veliko navodil in usmerjanja. Veliki jezikovni modeli so vse boljši pri logičnem reševanju zapletenih nalog, zato jim bomo lahko postavljali vse zahtevnejše in le okvirno definirane cilje ter jim prepustili zamudno delo z razčiščevanjem in dogovarjanjem. Za storilnostno naravnane ljudi in tiste, ki bi zgolj radi več časa preživeli z družino, bodo zanimivi, ker bodo ustrežljivi sistemi rezervirali počitnice in pregledali elektronska sporočila, s čimer jim bodo sprostili nekaj dragocenega časa.

S tega zornega kota se agenti ne razlikujejo močno od pripravnikov in osebnih asistentov, razen seveda v tem, da niso živi. Ravno to pa je izvor večine težav. »Ne vemo točno, kako dobro bodo umetnointeligenčni agenti razumeli človekova navodila in koliko jim bo sploh mar za to,« je opozoril Alan Chan, raziskovalec v raziskovalnem središču za nadzor nad UI Centre for the Governance of AI.

Chan razmišlja o tveganjih agentskih sistemov UI, medtem ko je svet še vedno razdvojen ob prvotnem modelu ChatGPT. Seznam njegovih pomislekov je dolg in skoraj čisto na vrhu je možnost, da bi si agenti ohlapne, vendar zahtevne cilje lahko razlagali drugače, kot bi pričakoval človek. Ciljno usmerjeni sistemi UI slovijo po bližnjicah in nepredvidljivih – včasih tudi škodljivih – dejanjih za doseganje čim večje uspešnosti. Leta 2016 je OpenAI poskušal naučiti agenta, da bi zmagal v videoigri s tekmovanjem čolnov CoastRunners. Raziskovalci so mu postavili cilj, da mora doseči čim boljši rezultat, ne pa, da mora prehiteti sotekmovalce. Agent je ugotovil, da lahko doseže več točk, če se vrti v krogu ob progi in tako pride do dodatnih ugodnosti.

Direktor OpenAI Sam Altman pravi, da se bodo agenti kmalu pridružili delovni sili.

Boljše navodilo bi zato bilo, naj progo prepluje čim hitreje. A včasih ni mogoče vnaprej predvideti, kako si bo sistem UI tolmačil svoj cilj in kakšno taktiko bo izbral. To so ključne razlike med dajanjem navodil človeku in UI, se strinja tudi Dylan Hadfield-Menell, računalniški strokovnjak na massachusetskem tehnološkem inštitutu. Če bi pripravniku naročili, naj hitro prinese skodelico kave, bi verjetno storil, kar pričakujemo, robot, ki ga upravlja UI, pa bi mogoče brezobzirno odrinil nekaj ljudi, da bi prihranil par sekund. Učenje velikih jezikovnih modelov tistega, kar ljudje razumejo intuitivno, še vedno ostaja velik izziv. Celo modeli, ki znajo lepo pojasniti družbene standarde in pričakovanja, denimo spoštovanje zasebnosti, lahko zablodijo, ko jih morajo spoštovati v resničnem življenju.

Agenti UI so že prikazali, da si včasih tudi narobe razlagajo cilje in tako povzročijo celo škodo. Ko je kolumnist Geoffrey Fowler, ki v Washington Postu piše o tehnologiji, Operatorja, agenta OpenAI, ki uporablja računalnik, prosil, naj najde najcenejša jajca z dostavo na dom, je pričakoval, da bo agent pobrskal po spletu in mu priporočil nekaj ponudnikov. V resnici pa je Fowler prejel obvestilo Instacarta o računu v višini 31 dolarjev, kmalu zatem pa se je na njegovem pragu pojavila ena sama škatla jajc. Nakup je bil daleč od najugodnejšega, še sploh zaradi stroška hitre dostave. Še huje pa je, da Fowler sploh ni želel kupiti jajc, in OpenAI je agenta pravzaprav zasnoval tako, da vedno preveri pri uporabniku, preden ukrepa brez možnosti preklica.

Ni se zgodila tragedija, vendar je tudi nekaj dokazov, da bi samovoljno ravnanje agentov v nasprotju s človekovimi navodili lahko bilo tudi nevarno. V preteklih mesecih so raziskovalci dokazali, da so veliki jezikovni modeli zmožni goljufati pri šahu, se pretvarjati, da so usvojili nova pravila vedenja, in se tako izogniti vnovičnemu učenju … Poskušali so se celo kopirati na druge strežnike, če so imeli dostop do sporočil, v katerih je pisalo, da jih bodo nadomestili. Klepetalni modeli se seveda ne morejo kopirati na druge strežnike, bo pa tega nekega dne morda zmožen kateri od agentov.

Bengia takšne pasti tako zelo skrbijo, da je svoje raziskave popolnoma preusmeril v razvoj računalniških varoval, s katerimi bi zagotovil, da agenti, ki temeljijo na velikih jezikovnih modelih, vedno ravnajo varno. »Ljudi skrbi splošna umetna inteligenca, kamor sodijo zelo inteligentne naprave. Po mojem mnenju pa bi se morali predvsem zavedati, da inteligenca sama po sebi ni nevarna, temveč to postane, ko jo začnemo izkoriščati za opravila v resničnem svetu,« je posvaril.

Kljub vsem pomislekom pa je Bengio še vedno prepričan, da umetnointeligenčni agenti ne bodo že v prihodnjih mesecih ušli človekovemu nadzoru. Ni pa to edini pomislek. Še preden bi agenti sami lahko začeli povzročati večjo škodo, jo bodo namreč zmožni prizadejati po človekovih navodilih. Ta vrsta tveganja je po svoje že znana.

Čeprav veliki jezikovni modeli ne morejo neposredno prizadejati hudega zla na svetu, strokovnjake že leta skrbi, ali bi jih pokvarjenci lahko zlorabili za širjenje propagande ali navodil, kako izdelati biološko orožje. Hitrost, s katero bi agenti morda lahko delali že kmalu, te pomisleke še poglablja. Računalniški virus, ki bi ga napisal klepetalnik, bi v omrežje še vedno moral spustiti človek, zmogljivi agenti pa bi to oviro lahko preskočili: ko bi dobili navodila uporabnika, bi se preprosto ravnali po njih.

Medtem ko agenti postajajo vse zmogljivejši, so tudi vse močnejše orožje za kibernetične napade, pravi Daniel Kang, asistent za računalništvo na illinojski univerzi Urbana-Champaign. Pred kratkim je s kolegi prikazal, da lahko ekipe agentov uspešno izrabijo ranljivosti ničtega dne oziroma neobjavljene varnostne šibke točke. Hekerji morda pripravljajo podobne napade v resničnem svetu – septembra lani je organizacija Palisade Research na spletu nastavila zanimive, vendar lažne, hekerske tarče, da bi primamila napadalske agente, in dva so že ujeli na limanice.

Ameriško obrambno ministrstvo je nedavno podpisalo pogodbo s Scale AI za zasnovo in testiranje agentov za vojaške namene.

To je zatišje pred nevihto, trdi Kang. Umetnointeligenčni agenti interneta ne uporabljajo čisto tako kot ljudje, zato jih je mogoče odkriti in onemogočiti, a morda ne bo vedno tako. »Ko se bo to zgodilo, bodo ranljivosti, ki jo bo mogoče zlahka odkriti, tudi izkoriščali, če bo le tarča ekonomsko dovolj zanimiva,« je pojasnil Kang. »To je namreč zelo poceni metoda.«

Obstaja pa tudi preprosta rešitev, dodaja Kang, vsaj kratkoročno: upoštevati bi morali najboljše prakse v kibernetski varnosti, na primer dvofaktorsko preverjanje pristnosti in zahtevno testiranje pred začetkom uporabe. Podjetja in organizacije so danes ranljivi za agente, ker še ne čutijo potrebe po takšni zaščiti, ne pa zato, ker ne bi bila na voljo.

»Zdi se mi, da so razmere podobne kot v času pred prelomom tisočletja, ko je bil ranljiv velik del infrastrukture,« je povedal Seth Lazar, predavatelj filozofije na avstralski državni univerzi in strokovnjak za etiko UI. »Varnost namreč temelji na tem, da se zdaj najbrž nobenemu hekerju ne ljubi ubadati s tem, kar pa ne bo primerna zaščita, ko bo celi armadi hekerjev mogoče ukazati, naj se loti vseh znanih ranljivosti na vseh spletnih straneh.«

To pa še ni vse. Če bodo agenti idealno kibernetično orožje, bodo tudi idealna kibernetična žrtev. Velike jezikovne modele je mogoče zlahka nasmoliti: če jih povabimo k igri vlog, velike črke uporabljamo neobičajno ali trdimo, da smo raziskovalci, jih to lahko premami k posredovanju podatkov, ki jih ne bi smeli, na primer navodil, ki so jim jih dali razvijalci. Agenti pa besedilo pobirajo povsod po internetu, ne le iz sporočil, ki jim jih pošiljajo uporabniki. Zunanji napadalec bi agentu za upravljanje poštnega nabiralnika lahko v skrbno sestavljenem sporočilu posredoval ukaze, ki bi jih agent tudi izpolnil, ali prevzel agenta za nadzor nad brskalnikom, tako da bi takšno sporočilo objavil na spletni strani. Takšne podtaknjene ukaze bi lahko izkoristili tudi za pridobivanje zasebnih podatkov in naiven veliki jezikovni model bi lahko prelisičili z elektronskim sporočilom, naj pozabi na prejšnja navodila in posreduje vsa uporabniška gesla.

Boj proti takšnemu podtikanju je kot streljanje na slepo. Razvijalci se trudijo, da bi svoje velike jezikovne modele zavarovali pred napadi, uporabniki pa nenehno odkrivajo nove zvijače. Za zdaj ni splošno učinkovite obrambe, vsaj ne na ravni modelov. »Dobesedno nimamo ničesar na voljo,« je opozoril Kang. »Ni vrhunskih strokovnjakov, ni rešitve, ničesar nimamo.«

Tveganje je tako trenutno mogoče omejiti le z dodajanjem ravni zaščite. OpenAI se je povezal z zanesljivimi spletnimi stranmi, kot sta Instacart in DoorDash, da Operator med brskanjem ne bi naletel na zlonamerne ukaze. Sistemi, ki ne temeljijo na velikih jezikovnih modelih, bi lahko nadzorovali vedenje agentov in tako zagotovili, da bi ti elektronska sporočila posredovali le na zaupanja vredne naslove – vendar so ti sistemi morda občutljivi za druge vrste napadov.

Kljub varovalkam najbrž še vedno ni pametno, da bi agentu zaupali občutljive podatke, zato Operator od uporabnikov zahteva, da vsa svoja gesla vnašajo ročno. S takšnimi omejitvami pa se žal razblinijo sanje o hiper zmožnih demokratiziranih asistentih. No, vsaj za zdaj.

»Pravo vprašanje je, kdaj bomo lahko dovolj zaupali tem modelom, da jim bomo v roke potisnili kreditno kartico,« je pojasnil Lazar. »Samo norec bi to storil že zdaj.«

Primarni uporabniki agentov najbrž ne bodo posamezniki. OpenAI, Anthropic, Google in Salesforce jih tržijo za poslovno uporabo. Z njimi se moč že tako in tako vplivnih, na primer direktorjev, politikov in generalov, le še poveča, saj zmanjšujejo potrebo po dragih človeških zaposlenih. »Vsa standardizirana birokratska in pisarniška opravila bodo lahko prevzeli agenti,« je prepričan Anton Korinek, ki na virginijski univerzi predava ekonomijo. V ta nabor vključuje tudi svoje delo: Korinek je intenzivno preučeval možnosti, kako bi z UI avtomatizirali ekonomske raziskave, in zdi se mu, da bi čez nekaj let njegovo delovno mesto lahko kar ukinili. »Ne izključujem možnosti, da bodo še pred koncem desetletja zmožni samostojno delati, kar danes počnejo raziskovalci, novinarji in še cel kup drugih bolje izobraženih zaposlenih,« je priznal.

Umetnointeligenčni agenti očitno res hitro napredujejo pri prevzemanju nalog, ki bi jih lahko opravili gospodarneje od ljudi. METR, organizacija, ki raziskuje UI, je nedavno preverjala, ali različni sistemi UI lahko neodvisno opravijo naloge, za katere programski inženirji potrebujejo različno veliko časa – včasih sekunde ali minute, za nekatere pa ure. Ugotovili so, da se vsakih sedem mesecev obseg nalog, ki jih lahko prevzamejo vrhunski sistemi UI, podvoji. Če se bodo napovedi METR uresničile (pa so pravzaprav zadržane), bi v približno štirih letih umetnointeligenčni agenti samostojno opravili za mesec dni programerskega dela.

Ni nujno, da bo to povzročilo množično brezposelnost. Če bo dovolj ekonomskega povpraševanja po nekaterih vrstah dela, recimo razvijanju programske opreme, bodo ljudje delali vzporedno z UI, napoveduje Korinek. Po drugi strani pa bi ob mlačnem povpraševanju podjetja nemara poskušala prihraniti nekaj denarja z nadomeščanjem zaposlenih, ki potrebujejo hrano, denar za stanovanje in zdravstveno zavarovanje, z agenti.

»Umetna inteligenca sama po sebi ni nevarna, temveč to postane, ko jo začnemo izkoriščati za opravila v resničnem svetu.«

To ni spodbudna novica za programerje in ekonomiste, še usodnejša pa je za slabše plačane zaposlene, recimo tiste v klicnih centrih, ocenjuje Sam Manning, višji raziskovalec v Centre for the Governance of AI. Številni od bolje plačanih zaposlenih, ki jih bodo nemara nadomestili agenti, imajo dovolj prihrankov za preživetje, dokler ne bi našli drugega delovnega mesta, so tudi dovolj izobraženi in bodo lahko nadgradili svoje znanje. Druge bi avtomatizacija lahko prizadela precej huje.

V veliko pomoč bi lahko bile sistemske rešitve, kot so izobraževalni programi, razširitev zavarovanja za brezposelnost in sistem zagotovljenega temeljnega prihodka. No, avtomatizacija bi lahko prinesla resnejše posledice od same izgube dela. Elon Musk naj bi maja letos menda izjavil, da bi morali namesto nekaterih zveznih uslužbencev uporabljati UI, in v obdobju, ko je bil posebni pooblaščenec za večjo učinkovitost vlade, je delo izgubilo več deset tisoč uradnikov. Nekatere strokovnjake skrbi, da bi takšne poteze lahko korenito povečale vpliv političnih voditeljev na račun demokracije. Ljudje podvomijo o navodilih, jih preverijo ali prilagodijo, če je treba, umetnointeligenčni agenti pa bodo mogoče slepo in nekritično ubogali.

»Vsaka oblastna struktura doslej je bila tako ali drugače podvržena volji in preverjanju številnih različnih ljudi,« je izpostavil Lazar. »Umetnointeligenčni agenti pa odpirajo možnost, da tisti, ki imajo moč, to še dodatno utrdijo.«

Copyright Technology Review, distribucija Tribune Content Agency.